| title | type | weight | lastmod | |

|---|---|---|---|---|

Develop |

docs |

1 |

|

-

-

Save showa-93/ec10db8e4fdd60148e6acd61641b9192 to your computer and use it in GitHub Desktop.

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Microservices |

docs |

showa |

|

1 |

- マイクロサービスパターン[実践的システムデザインのためのコード解説]

- microservices.io

- Building Microservices in Go: Caching using memcached - DEV Community

システム操作とは、アプリケーションが処理するリクエストを抽象化したもの。ドメインモデルに対するふるまいを定義する仕様。

ふるまいの定義とは、システム操作が呼び出されたときに満たすべき前条件と、操作終了後に満たさないとならない後条件。これらを定義するために、高水準のドメインモデルを定義する必要がある。

ビジネスに合わせて分割するサービスを定義する

- 業務に合わせてサービスを定義する

- [ドメイン駆動設計]のサブドメインとして定義

サービスの分割に対するガイドライン⇛[サービスの分割]

個々のサービスのAPIを定義する

- システム操作のサービスへの割当

- 基本的にはサービスに関係のあるシステム操作を割り当てる

- システム操作が提供する情報を必要とするサービスに割り当てる

- サービス間の連携

- システム操作が満たすべき前条件と後条件を満たすように呼び出すサービスを決める

ただし、サービス間で連携する場合、下記に注意が必要

- ネットワークのレイテンシ

- サービス間の同期通信による可用性の低下

対応表

| 1対1 | 1対多 | |

|---|---|---|

| 同期的 | リクエスト/レスポンス | - |

| 非同期的 | 非同期リクエスト/レスポンス | パブリッシュ/サブスクライブ |

| 一方通行の通知 | パブリッシュ/非同期レスポンス |

- [同期的なリモープロシージャパターン]

- リクエスト/レスポンス:同期的な通信。サービス間が密結合になる。

- [非同期的メッセージングパターン]

- 非同期リクエスト/レスポンス:リクエストしたクライアント側がレスポンスを待つブロックをしない状態

- パブリッシュ/サブスクライブ:クライアントがメッセージをパブリッシュし、サブスクライブした0個以上のサービスがメッセージを消費する

- パブリッシュ/非同期レスポンス:パブリッシュしたクライアントが特定のサービスからのレスポンスを待つ

- 一方通行の通知:サービスにリクエストを送るが、レスポンスは期待しない

セマンティックバージョニングを使うことで、互換性のないAPIの更新によって、利用しているサービスがダウンしないような設計を心がける。

セマンティックバージョニングに従うために、以下のような観点でバージョン番号を設定する。

-

Major:APIに互換性のない変更を加えるときにインクリメントする

- HTTPベースの場合、パスにバージョンを組み込んだり、MIMEタイプにversionを含めることで互換性を保つ

-

Minor:APIに下位互換のある変更を加えるときにインクリメントする

- 前提として、堅牢性の原則に従うようにすると下位互換のある変更であれば、古いバージョンのクライアントでも問題ない

- リクエストにオプション属性の追加

- レスポンスの属性の追加

- 新しい操作の追加

-

Patch:下位互換性のあるバグフィックスをするときにインクリメントする

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

非同期的メッセージングパターン |

docs |

showa |

|

1 |

クライアントとサービスの間で対になるメッセージをやり取りする形でインタラクションを実装する。メッセージングを用いているため、非同期的な通信になるが、リプライがあるまでブロックすることで同期的に通信ができる。

- リクエストのメッセージで相関IDとリプライを返すためのチャネルを設定してチャネルに送信する

- リプライでは、リクエストでしていされた相関IDを設定してリプライチャネルに送信する

- クライアントは、リプライチャネルから相関IDに一致するメッセージを取得する

ドメインオブジェクトに変更が加えられたことを表すドメインイベントをパブリッシュするために使う。

チャネルはドメイン名から作ったものにする。特定のドメインオブジェクトに関心を持つサービスが適切なチャネルをサブスクライブするだけでイベントを検知できる。

前述の2つを組み合わせたインタラクションスタイル。

- クライアントは、相関IDとリプライチャネルを指定したメッセージをパブリッシュする。

- コンシューマ(メッセージの消費者)は、相関IDを含んだメッセージをリプライチャネルにパブリッシュする。

- クライアントは、相関IDを使ってリプライメッセージを集める

非同期メッセージングでサービス間のトランザクションを保つ方法

- Transactional outbox パターン

- レコードの変更をOutboxテーブルに保存してイベントを同一トランザクションで保存することで、イベントが発行されることを担保する

- Poling publlisher パターン

- Outboxテーブルをポーリングしてメッセージングをパブリッシュする

- DBへのアクセス負荷が高くなる可能性がある

- Transaction log tailing パターン

- データベースのトランザクションログをログマイナーで読み取り、変更点をメッセージブローカーにパブリッシュする

- データベース固有APIを呼び出す低水準コードを書く

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Circuit Breakerパターン |

docs |

showa |

|

1 |

リモートコールで呼び出し先で障害が発生した場合、呼び出しに失敗したり、応答を待ち続けることになる。

多くの呼び出しが発生した場合、リソース不足になり、連携している複数のシステムに連鎖的に障害が発生する可能性がある。

Michael Nygard氏は、著書「Release It」の中でこのような問題を防ぐためにCircuit Breakerパターンを提唱した。

リクエストの成否を数え、エラー率がしきい値を超過したらサーキットブレーカーを作動させ、その後一定の時間がすぎるまでリクエストを失敗させる。(障害が発生したサービスへのリクエストを遮断)

一定の時間がすぎると、決められた数の試験的なリクエストをおこない、成功すればサーキットブレーカーは通常動作に戻る。失敗する場合は、再度リクエストを失敗させるタイムアウト期間に入る。

TODO: パターンについてまとめる

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

補償トランザクション |

docs |

showa |

|

1 |

(compensating transaction)ローカルトランザクションが失敗した場合、それまでの別サービスのローカルトランザクションを取り消す操作を実行する必要がある。

- 補償可能トランザクション(compenstable transaction)

補償トランザクションを使ってロールバックされる可能性があるトランザクション - ピポットトランザクション

処理を最後まで実行するか、キャンセルするか判断するポイントとなるトランザクション

ピポットトランザクションがコミットされると最後まで実行される - 再試行可能トランザクション

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

カウンターメジャー |

docs |

showa |

|

1 |

countermeasure 分離性の欠如に対処するための設計手法。

あるサーガが加えた変更を他のサーガが取り消す形で書き換えたときに本来あるべき更新の状態が消失してしまう。

あるサーガが更新している途中のデータを他のサーガが読み取ってしまう。

サーガがデータを読み取った後に、他のサーガが該当のデータを書き換えて参照されているデータの値がまちまちになってしまう。

[補償可能トランザクション]は、作成・更新するレコードにフラグをセットする。 フラグによってレコードの状態(ロック中かなど)を管理する。 アプリケーションでロック管理、デッドロックの検出を行う必要がある、

どんな順序で実行しても影響のない更新操作を交換可能と呼ぶ。 他のサーガの更新結果を上書きしないような処理であるため、更新結果の消失の可能性を排除できる。

ダーティリードによるビジネスリスクを最小限に抑えるようにステップの順序を並び替える。

楽観的オフラインロックの一種。 値を更新する前に読み直し、変更されていないことを確認してからレコードを更新する。 レコードが書き換えられている場合、サーガを中止する。

レコードに対して実行された操作を記録し、実行順序をかえられるようにする。 交換不能な操作を交換可能な操作に変更する。

ビジネスリスクに基づいて、利用する並行処理のメカニズムを選択する。 個々のリクエストの性質に基づいてサーガと分散トランザクションを使うか判断する。

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

メッセージブローカー |

docs |

showa |

|

1 |

メッセージブローカーは、基本的にAt least oneceを保証している。そのため、2回以上メッセージが飛ばされる可能性がある。

- 冪等なメッセージハンドラ

- アプリケーションのメッセージの処理が冪等であるように作る

- 重複メッセージを破棄

- メッセージを処理するときに消費したメッセージIDをテーブルに格納する

- 消費済みのメッセージを受けたときは登録に失敗するため検知できる

Apache Kafka、RabitMQとかとか

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Saga |

docs |

showa |

|

1 |

マイクロサービスのように個々にDBを有する複数のサービスをまたいだACDトランザクションを保証できる。[カウンターメジャー]によって、[分離性](独立性)がないことによる並行処理の異常の影響を防ぐ必要がある。

サーガのステップ通りに動かすコーディネートコードが参加サービスのトランザクションの実行指示をする。コーディネートコードの実装方法には以下の2種類の方法がある。

サーガの参加サービスに次のステップの判断を委ねる分散管理の方法。参加サービスはイベントを交換して通信をおこなう。

- 参加サービスはトランザクションの一部としてイベントをパブリッシュする必要がある

- データベースの更新とイベントのパブリッシュをアトミックに行う必要がある

- Transactional messagingパターンを利用する

- 参加サービスは受け取ったイベントを自分のデータに対応付ける必要がある

- 相関IDを含めたかたちでイベントをパブリッシュするようにする

メリット

- 単純性:サービスはオブジェクトを作成、更新、削除したときにイベントをパブリッシュする

- 疎結合:イベントをサブスクライブするだけで、お互いについて直接的な知識をもたない

デメリット

- サーガを定義しているコードがまとまっていないため、わかりづらい

- 循環的な依存関係が発生する可能性がある

- サービスが密結合になる可能性がある

サーガオーケストレートクラスでコーディネートロジックを一元管理する方法。起動の起点となるサービスでオーケストレータを作成し、サーガのステップを管理する。

参加サービスと通信を行い、サーガのステップを実行するために参加サービスにコマンドメッセージを送る。

オーケストレータを作成したサービスへのコマンドも参加サービスの1つとしてコマンドメッセージを経由して処理する。

メリット

- コレオグラフィに比べて循環依存がないため依存関係が単純

- コレオグラフィよりも疎結合。参加サービスがパブリッシュイベントについて知識が不要になる

- コーディネートのロジックがオーケストレタにまとめられるため、ドメインがサーガについての知識をもつ必要がなくなる

デメリット

- オーケストレタにビジネスロジックが集中してしまう可能性がある。ファット

状態マシンでモデリングすることで、状態とアクションを紐付けられるため、設計・実装・テストが簡単になる。

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

サービスディスカバリ |

docs |

showa |

|

1 |

サービスディスカバリメカニズムは、サービスインスタンスが起動・終了したときにサービスレジストリを更新する。クライアントがサービスを呼び出すと、サービスディスカバリメカニズムはサービスレジストリにクエリを送り、利用できるインスタンスの一覧を取得し、どれかにルーティングする。

サービスディスカバリとそのクライアントがサービスレジストリを操作する アプリケーションレベルでサービスディレクトリが存在すると、プラットフォームをまたいでサービスが存在しても、処理できるというメリットがある。

- Self registration パターン

- サービスインスタンスがサービスレジストリの登録APIを呼び出して自分のアドレスを登録する

- Client-side discovery パターン

- クライアントがサービスレジストリからリストを取得し、クライアント自身でバランシングアルゴリズムを使ってサービスインスタンスを選択する

DockerやKubernatesなどのデプロイプラットフォームは、組み込みでサービスがレジストリとディスカバリメカニズムを持っている。 プラットフォームが提供する最大の利点は、プラットフォームを利用する側が意識せずともサービスディスカバリを行ってくれるという点にある。また、サービスにもクライアントにもサービスディスカバリのためのコードが含まれなくなるため、言語やフレームワークに依存せずに利用ができる。

- 3rd party registration パターン

- サービスがレジストリに登録するのではなく、サードパーティであるレジストラが登録処理をする

- サービスのソースコードが影響を受けない。

- また、サービスインスタンスにヘルスチェックをおこない、インスタンスの登録/登録解除を行える

- Server-side discovery パターン

- クライアントでレジストリに問い合わせずに、DNS名をリクエストルーター(ロードバランサー)に送り、ルーターがサービスレジストリに問い合わせし、利用可能なサービスインスタンスにリクエストの転送を行う

- AWS Elastic Load Balancerなどで提供されている

- [https://scrapbox.io/files/60b78ce84b9ae5001cf91206.png]

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

サービスの分割 |

docs |

showa |

|

1 |

オブジェクト指向設計の原則のうちの2つを意識するとよりよいアーキテクチャの設計の指針になる。

- 単一責任の原則

- クラスを書き換える理由は1つでなければならない

- 各サービスでこの原則が貫かれていれば、小さい単一の責務を担うサービスにできる

- 閉鎖性共通の原則

- 1つのパッケージにまとめられるクラス郡は同じ種類の変更に対してともに影響をうけるべきである。

- ビジネスルールが変更されたときの影響が最小限になるように抑える

業務(business capability)による分割のパターン。

業務とは、企業が価値を生成するためにおこなう仕事の種類。業務自体が変更が少なく安定しているため、アーキテクチャ自体も安定しやすいというメリットがある。

- 業務の洗い出し

企業の目的、構造、ビジネスプロセスから洗い出す - 業務からサービスを定義

ここの業務または、業務グループのために1つのサービスを定義する

[ドメイン駆動設計]を用いた分割パターン。

ドメインからサブドメインを洗い出し、サブドメインごとにドメインモデルを定義する。ドメインモデルの範囲を境界づけられたコンテキストと呼ぶ。

個々の境界づけられたコンテキストは、サービスまたは、サービスを束ねるグループとして扱えるゾ。

ドメインモデル:ドメイン内の問題解決に使えるドメインの知識を捉えている

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

同期的なリモープロシージャパターン |

docs |

showa |

|

1 |

クライアントとサーバー間がプロキシインターフェースを介して同期的に(クライアントがレスポンスを期待して)やり取りを行う。プロキシインターフェースが通信のプロトコルをカプセル化する。

通信のプロトコルとして、RESTとgRPCについて取り上げる。

RESTは、ビジネスオブジェクトやそのコレクションを表すリソースを、HTTPメソッドで操作するようにエンドポイントをもつAPI。APIは、インターフェース定義言語で定義しなければならない。

メリット

- curlやPostmanで簡単にAPIを叩くことができる

- リクエスト/レスポンススタイルをサポートしている

- 中間のブローカーが不要でアーキテクチャが単純になる デメリット

- リクエスト/レスポンススタイル以外の通信を利用できない

- クライアントーサーバー間が直接通信しているので、可用性が下がる

- クライアントがサービスインスタンスの位置を知っている必要がある

- (解決策⇛[サービスディスカバリ])

- 1つのリクエストで複数のリソースをフェッチできない

HTTP/2を利用してプロトコルバッファ形式のメッセージをやりとりするAPI。

メリット

- 操作に対して命名できるのでAPIの設計がしやすい

- 大きなメッセージのやりとりでも効率的でコンパクトに通信できる

- 双方向ストリーミングのため、RPI、メッセージの両方のスタイルで通信できる

- 言語に依存しない

デメリット

- JavaScriptクライアントでは扱いづらい

- 古いファイアウォールでは対応していない場合がある

同期的にサービスを呼び出す場合、以下について検討し、障害から守る必要がある。

fault-tolerance-in-a-high-volume-distributed-system - netflix

- レスポンスを待つときはネットワークタイムアウトを指定する。リソースが必ず開放されるようにする。

- クライアントから未応答のリクエストの許容上限を決めておく

- [Circuit breaker パターン]

サービス障害時のエラーの修復としては

- クライアントにエラーを返す

- デフォルト値やキャッシュした値を返却する

- サービスそのものが障害で動作しない可能性もあるため、適切にサービスを

| title | type | weight | lastmod | |

|---|---|---|---|---|

Architecture |

docs |

2000 |

|

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Action Domain Responder |

docs |

showa |

|

1 |

Action-domain-responder(ADR)は、Webアプリケーションにより適したModel-view-controller(MVC)の改良版としてPaul M. Jonesによって提案されたソフトウェアアーキテクチャパターンです. MVCと最も異なる部分は、1つのパスに対して1つのAction Classであることがあげられる。 コントローラの場合、複数のパスがメソッドによって表現されるが、これによってあるメソッドでは必要でも他のメソッドでは必要のない依存関係などがうまれたり、クラス内の複雑性は変更が加えられるたびにFatになっていく。(そして神クラスへ...) ADRでは、1つのActionでは1つのパスしか表現できないので、こうしたクラスの肥大化を防ぐことができる。 また、responseを返す部分をResponderとして切り分けられているため、より疎結合な実装が可能になる。

| title | type | weight | lastmod | |

|---|---|---|---|---|

Links |

docs |

100000 |

|

- 設計・ソフトウェアアーキテクチャを学べるGitHubリポジトリ 16選

- Awesome Software Architecture

- O'Reilly Japan - ソフトウェアアーキテクチャの基礎

- O'Reilly Japan - ソフトウェアアーキテクチャ・ハードパーツ

- nealford.com • Architectural Katas

- asynkron/protoactor-go: Proto Actor - Ultra fast distributed actors for Go, C# and Java/Kotlin

- Actorモデルのライブラリ

- システムの複雑さはどこから来るのか – Out of the tar pitを読む - Uzabase for Engineers

- モノリスとマイクロサービスを経てモジュラモノリスを導入した実践事例 - Speaker Deck

- モジュラモノリスにおけるトランザクション設計の考え方 / transaction design on modular monolith - Speaker Deck

- How to (and how not to) design REST APIs · stickfigure/blog Wiki

- API仕様ファースト開発:柴田 芳樹 (Yoshiki Shibata):SSブログ

- API 設計ガイド | Cloud APIs | Google Cloud

- 実践Immutable Data Model - 紙箱

-

Updateをなるべく発生させないためには、データを改変できない(つまりCreateしかできない)モデルの方が、長期的に安定した、安全なシステムが作れるはず、という考え方です。

-

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

低レイヤのお勉強 |

docs |

showa |

|

100500 |

Compiler Explorer

Cソースからアセンブリを出力してくれるサイト

.intel_syntax noprefix ;アセンブリの文法指定.x86-64

.globl plus, main ;プログラム全体のグローバルな関数であることを明示

plus:

add rsi, rdi

mov rax, rsi ;関数のリターンは、RAXレジスタに設定

ret

main:

mov rdi, 3

mov rsi, 4

call plus

ret- 関数のリターンは、RAXレジスタに設定する

- 関数の第一引数 RDIレジスタ、第二引数 RSIレジスタに入れる

call: 関数の呼び出し命令- callの次の命令のアドレスをスタックにプッシュ(戻ってくるアドレス)

- callの引数としてアドレスにジャンプ

- 四則演算: 第一引数のレジスタに結果を上書く

add: 足し算sub: 引き算imul: 符号あり掛け算- mul: 乗算。オペランドを1つとる

- mul rdi => rax = rax rdi

idiv: idivは暗黙のうちにRDXとRAXを取って、それを合わせたものを128ビット整数とみなして、それを引数のレジスタの64ビットの値で割り、商をRAXに、余りをRDXにセットする

mov: 第一引数に第二引数をコピーする- code:mov dst [rax]

- raxに入っているアドレスからメモリの値をロードして、dstに値をセットする

- code:mov [dst] src

- dstの値をアドレスとみなして、そのアドレスのメモリにsrcの値をストアする

- ⇒[]でレジスタの値をアドレスとして、メモリの内容にアクセスしてる?

- code:mov dst [rax]

- comp:

「フラグレジスタ」に比較結果をセットする

cmpの実体は、「フラグレジスタ」だけを更新する特殊なsub命令

setxxxで「フラグレジスタ」から8bitレジスタに書き込むsetl: より小さい場合バイトを設定(>,<)setle: より小さいか等しい場合バイトを設定(>=,<=)setne: 等しくない場合バイトを設定(!=)sete: 等しい場合バイトを設定(==)

ret: 呼出し元関数の実行を再開- スタック(RSP)からアドレスをpop

- popしたアドレスにジャンプ

- スタックポインタ: RSPレジスタをスタックポインタとして、RSPレジスタが指すメモリにアクセスできる

poppush

- cqo: 符号拡張。RAXに入っている64ビットの値を128ビットに伸ばしてRDXとRAXにセットする

- ジャンプ: 今いる命令のアドレスから、指定されたアドレスの命令のアドレスに移動することです.

- RAX

- RDI

- RSI

- RSP

- RBP

- 「ベースレジスタ」。関数フレームの開始位置を指すレジスタ。

- ここに入っている値を「ベースポインタ」と呼ぶ。

- ベースポインタを利用することで、RSPにpushされているローカル変数や関数パラメータを、RBPからの相対位置で変数にアクセスできるようにしている。

- What is the purpose of the RBP register in x86_64 assembler? stackoverrun

- AL

- ALはRAXの下位8ビットを指す別名レジスタ。RAXをAL経由で更新するときに上位56ビットは元の値のままになるので、RAX全体を0か1にセットしたい場合、上位56ビットはゼロクリアする必要があります。

スタックマシンは、スタックをデータ保存領域として持っているコンピュータのことです。したがってスタックマシンでは「スタックにプッシュする」と「スタックからポップする」という2つの操作が基本操作になります。プッシュでは、スタックの一番上に新しい要素が積まれます。ポップでは、スタックの一番上から要素が取り除かれます。

スタックマシンにおける演算命令は、スタックトップの要素に作用します。例えばスタックマシンのADD命令は、スタックトップから2つ要素をポップしてきて、それらを加算し、その結果をスタックにプッシュします(x86-64命令との混同を避けるために、仮想スタックマシンの命令はすべて大文字で表記することにします)。別の言い方をすると、ADDは、スタックトップの2つの要素を、それらを足した結果の1つの要素で置き換える命令です。(movzb命令)

;スタックポインタを用いた加算

;ex) 1+2

push 1

push 2

pop rdi;2

pop rax;1

add rax rdi

push rax;3Cでは、変数領域をスタック(RSP)上にもつ。

関数ごとにRSPでリターンアドレスと関数呼び出しで使われるメモリ領域を管理する。このメモリ領域のことを「関数フレーム」や「アクティベーションレコード」と呼ぶ。

| ... | ||

|---|---|---|

| 関数gのリターンアドレス | ||

| ローカル変数 | a | |

| ローカル変数 | b | ←RSP |

ただし、上記ではRSPが変更(push/pop)されるたびに、ローカル変数へのアクセスがRSPからのオフセットで利用できない。そのため、RSPとは別に関数フレームの開始位置を指す「ベースレジスタ」を用意する。

このレジスタの値を「ベースポインタ」と呼ぶ。

| ... | ||

|---|---|---|

| 関数gのリターンアドレス | ||

| 関数gの呼び出し時典のRBP | ←RBP | |

| ローカル変数 | a | RBPからの相対位置でアクセス可能 |

| ローカル変数 | b | ←RSP |

関数fを関数gで呼び出すと

| ... | ||

|---|---|---|

| 関数gのリターンアドレス | ||

| 関数gの呼び出し時典のRBP | ||

| ローカル変数 | a | |

| ローカル変数 | b | |

| 関数fのリターンアドレス | ||

| 関数fの呼び出し時典のRBP | ←RBP(関数gの呼び出し時点のRBPの位置を記録) | |

| ローカル変数 | x | |

| ローカル変数 | y | ←RSP |

この関数呼び出し時のスタックの状態を作るアセンブリは下記のようになる。この定型の命令のことを「プロローグ」と呼ぶ。

push rbp ;今のrbpをスタックにpush

mov rbp, rsp ;rbpにpushしたrbpの位置をrbpに保持

sub rsp, 16 ;必要な分だけ関数フレームを取得(メモリ確保)関数からリターンするときは、RBPを書き戻して、RSPがリターンアドレスを指している状態でret命令を呼ぶ。これを実現する下記のような定型の命令のことを「エピローグ」と呼ぶ。

mov rsp, rbp ;rspをrbpの位置に移動

pop rbp ;rbpを前の値に書き換える

ret ;リターンアドレスの位置に移動| ... | |

|---|---|

| 関数gのリターンアドレス | |

| 関数gの呼び出し時典のRBP | |

| ローカル変数 a | |

| ローカル変数 b | |

| 関数fのリターンアドレス | |

| 関数fの呼び出し時典のRBP | ←RBP |

| ローカル変数 x | |

| ローカル変数 y | ←RSP |

| ... | |

|---|---|

| 関数gのリターンアドレス | |

| 関数gの呼び出し時典のRBP | |

| ローカル変数 a | |

| ローカル変数 b | |

| 関数fのリターンアドレス | |

| 関数fの呼び出し時典のRBP | ←RBP, RSP |

| ... | |

|---|---|

| 関数gのリターンアドレス | |

| 関数gの呼び出し時典のRBP | ←RBP |

| ローカル変数 a | |

| ローカル変数 b | |

| 関数fのリターンアドレス | ←RSP |

| ... | |

|---|---|

| 関数gのリターンアドレス | |

| 関数gの呼び出し時典のRBP | ←RBP |

| ローカル変数 a | |

| ローカル変数 b | ←RSP |

メモリとXMM0系レジスタ間で値を転送する命令では、メモリ上の値が16バイト境界に配置されていることを求める。 コンパイラは、関数呼び出し時のスタックポインタが16バイト整列されていることを前提に命令を発行するため、16バイト整列するように調整する責任がある。

| title | type | weight | lastmod | |

|---|---|---|---|---|

AWS |

docs |

1000 |

|

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Cloud Formation |

docs |

showa |

|

1 |

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

DynamoDB |

docs |

showa |

|

1 |

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

IAM |

docs |

showa |

|

1 |

| title | type | weight | lastmod | |

|---|---|---|---|---|

Links |

docs |

100000 |

|

- Introduction - AWS Lambda - 2023/05/11

- Lambdaのベストプラクティスについて書かれている

- ECSサービスの設計ポイントをざっくりまとめてみる - NRIネットコムBlog - 2023/05/20

- Global AcceleratorとCloudFrontの違いが見えてきたら解るCloudFrontの活用方法 - NRIネットコムBlog - 2023/05/20

- 全AWSエンジニアに捧ぐ、CloudWatch 設計・運用 虎の巻 / CloudWatch design and operation bible - Speaker Deck - 2023/05/31

- 半年前に勉強会で話したAWS VPCルーティングについて改めて整理してみた - NRIネットコムBlog - 2023/05/31

- Let’s Architect! Designing architectures for multi-tenancy | AWS Architecture Blog - 2023/06/20

- AWS Shield AdvancedのTips - Qiita - 2023/06/28

- AWS Sketch - 2023/07/21

- 各サービスについてのスケッチ

- 【15分で確認】AWSでクラウド構築する時に覚えておきたい設計原則・アーキテクチャ3選 - Qiita - 2023/09/17

- AWSのネットワーク設計入門

- 個人的AWS ログ管理のベースライン - mazyu36の日記

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

S3 |

docs |

showa |

|

1 |

| title | type | weight | lastmod | |

|---|---|---|---|---|

Bash |

docs |

100600 |

|

- シェルスクリプトの ( ) と の違いを歴史的に解説 〜 言語設計者の気持ちになって理解しよう - Qiita

- シェルスクリプト(bash)のif文やwhile文で使う演算子について - Qiita

- 変数内の文字列置換

- shellの引数

- 値が配列に存在するかチェック

- find

- sed

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

C |

docs |

showa |

|

100100 |

buf1 と buf2 を先頭から n バイト分比較します。比較はunsigned char として行われます。memcmp() は buf1 と buf2 をメモリブロックとして扱うため、途中に空文字('\0')を含んでいても比較を続けます。

#include <string.h>

int memcmp(const void *buf1, const void*buf2,size_t n); int main(void){

int hoge = 1;

switch(hoge) {

case 1:

printf("1やで");

case 2:

printf("2やで");

default:

printf("君だれ?");

}

}関数は呼び出す前にコンパイラに情報を渡すために、プロトタイプ宣言する必要がある。

gccなどでは、プロトタイプ宣言がなくてもコンパイルできるが、基本はエラーとなる。

また、main関数は、プロトタイプ宣言する必要のない特別な関数。

int number(void); # プロトタイプ宣言

int main(void){

int i = 0;

for(;;) {

printf("%d回目\n",number());

if(i>5){

break;

}

i+=1;

}

}

int number(void){

return 5;

}char型を利用する。ただし、255種(8bit)しか扱えないため全角文字は扱えない。 文字の比較とかの標準ライブラリ:[ctype.h https://www.programiz.com/c-programming/library-function/ctype.h]

C言語では、文字列を配。または文字リテラルで表す。

文字列の最後(EOS)は\0で表す。

int main(void){

char str[6] = {'A', 'B', '\0'};

printf("%s\n", str);

// ""で囲めば宣言できるが、初期化の時にしかつかえない

char str[] = "hoge";

printf("%s\n", hoge);

char input[32];

scanf("%s", input);

printf("%s\n",input);

printf("%ld\n", strlen(input));

return 0;

}int main(void){

int i;

printf("%p\n", &i);

int arr[4];

printf("array %p\n", arr);

for(i = 0; i < 4; i++){

printf("%d %p\n", i, &arr[i]);

}

intp1;

// nilになる

printf("pointer %p\n", p1);

// 0を代入してもnullポインタになる

p1 = 0;

printf("pointer %p\n", p1);

intp2;

i = 3;

p2 = &i;

printf("p2: %p i: %p\n", p2, &i);

i = 4;

printf("p2: %d i: %d\n", *p2, i);

*p2 = 6;

printf("p2: %d i: %d\n", *p2, i);

return 0;

} #include <stdio.h>

void hoge(int a[]);

int main(void){

int input[5] = {1, 2, 3, 4, 5};

printf("before: %d\n", input[2]);

hoge(input);

printf("after: %d\n", input[2]);

return 0;

}

void hoge(int a[]){

a[2] = 100;

}[]はあくまでも配列の先頭のポインタからの演算子。 配列は、先頭から連続したアドレスで作られるので、[]の演算子で値がとれる。

多くの人が、配列とポインタを勘違いしてしまうようです。 配列とは、多数の変数を順番つけでまとめて扱う方法であり、 ポインタとは、変数のショートカットを作る方法です。

それなのに、似たような使い方が出来るのは配列の設計と関係あります。 C言語では、配列を実現する手段として、ポインタを利用しているからです。 従って、ポインタ変数では、配列と同等のことが出来てしまいます。

そのため、ポインタと配列は混同しやすいのですが、 配列はあくまでも多数の変数の先頭を示す固定された変数であり、 ポインタ変数は、好きな変数のアドレスを代入して、 好きなメモリ領域を使うことが出来る可変的な変数です。

// studentのことを「構造体タグ名」と呼ぶ

// 厳密には型名じゃない

struct student_tag {

int year; /学年 */

int clas; /クラス */

int number; /出席番号 */

char name[64]; /名前 */

double stature; /身長 */

double weight; /体重 */

};

// 構造体型

typedef struct student_tag student;

void student_print(student *data);

/*

一番簡潔な書き方

typedef struct {

int year;

int clas;

int number;

char name[64];

double stature;

double weight;

} student;

*/

int main(void){

// typedef 指定指定ない場合、structを頭につける必要がある

// struct student_tag data

student data;

data.year = 1;

student_print(&data);

strcpy(data.name,"MARIO");

retrun 0;

}

void student_print(student *data){

printf("%d\n", (*data).year);

// ポインタの構造体変数は、「->」でアクセス可能

printf("%d\n", data->year);

(*data).year = 100;

return;

}-

構造体の中の配列

構造体の中に配列が含まれている場合は、配列の中身もコピーされて渡されます。 従って、中身を変更しても、呼び出し元の変数には影響しません。 配列をコピーして渡したい時(例えば、リバーシのプログラムで盤面情報を渡したい等)には、 構造体にしてしまうのが一番簡単です。 従って、構造体の配列を渡すのはとても遅いので、場合によってはやめたほうがいいこともあります

#include <stdio.h>

#define EXCISETAX 0.03 /ここで定数を宣言 */

int main(void)

{

int price;

printf("本体価格:");

scanf("%d",&price);

price = (int)((1 EXCISETAX) price); /定数使用 */

printf("税込価格:%d\n",price);

return 0;

}constよりはdefineのが一般的に使われる。 関数内定数や、関数の引数の型として使われることが多い。

#include <stdio.h>

int main(void)

{

const double EXCISETAX = 0.05;

int price;

printf("本体価格:");

scanf("%d",&price);

price = (int)((1 EXCISETAX) price);

printf("税込価格:%d\n",price);

return 0;

} enum {

ENUM_0,

ENUM_1,

ENUM_5 = 5, // 整数値を直接指定できる

ENUM_6, // 6

ENUM_7,

ENUM_9 = 9,

};#define疑似命令による定数は、単なる置き換えによって実現されている。

#include <stdio.h>

// 関数の呼び出しを置き換えることができる

#define PRINT_TEMP printf("temp = %d\n",temp)

int main(void)

{

int temp = 100;

PRINT_TEMP;

return 0;

}この機能によってマクロという簡単な関数をつくることができる。多用は非推奨。

#include <stdio.h>

// ()を使うと引数のように置き換えられる

#define PRINTM(X) printf("%d\n",X)

int main(void)

{

int a1 = 100,a2 = 50;

PRINTM(a1);

PRINTM(a2);

return 0;

}必要なメモリサイズを指定するとそのサイズを確保する。 確保した後、先頭のvoid型のポインタを返す。

mallocで確保されたメモリの解放処理。 mallocで確保されたメモリはプログラム終了まで確保されるので、メモリリークにならないように必ず開放する。

拡張元の配列の要素数を拡大する。 reallocによって、新たにメモリの領域を確保し、そこに拡張元の配列のコピーを行う。

int main(void)

{

int *heap;

heap = (int *)malloc(sizeof(int) 10);

// これだと元のheapのアドレスで確保したメモリがメモリリークしてるので、

// 別変数に突っ込んで解放してあげる必要ある。

heap = (int *)realloc(heap,sizeof(int) 100);

free(heap);

return 0;

}- [メモリの動的な確保と解放 https://kaworu.jpn.org/c/%E3%83%A1%E3%83%A2%E3%83%AA%E3%81%AE%E5%8B%95%E7%9A%84%E3%81%AA%E7%A2%BA%E4%BF%9D%E3%81%A8%E8%A7%A3%E6%94%BE]

宣言だけを行い定義は行わない宣言方法。ヘッダーファイル内で利用する。 宣言を行った変数の定義をどこか1つのソースファイルの中で普通の宣言を行って実体を作成して利用する。 extern宣言を使うと、異なるソースファイルで変数を共有することが出来る。

extern int Number; #include "hoge.h"

int Number;

int sum(int x) {

Number += x;

return Number;

}(あんまりC言語関係ない)

キャリッジリターン(\r)を使用すると、行の先頭に移動する制御になる。

コンソールの出力は上書きになるため、1行の範囲なら出力内容の更新が可能。

.ccファイル中に、ファイル外から参照される必要がない定義を行うときは、それらを無名の名前空間内で宣言するか、staticに宣言します。 これらの宣言を.hにおいてはいけません。

- Kilo Github

- 1000行でできたC言語製のCUIテキストエディタ

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

ChatGPT |

docs |

showa |

|

100200 |

プロンプトエンジニアリングで可能な例やアプリケーションをさらに多く取り上げるにつれて、プロンプトを構成する特定の要素があることに気付くでしょう。プロンプトには、以下のコンポーネントが含まれます。

- 指示 - モデルに実行してほしい特定のタスクや指示

- 「書く」「分類する」「要約する」「翻訳する」「並べ替える」など、モデルに目的を達成させるよう指示するコマンドを使って、さまざまなシンプルなタスクに効果的なプロンプトを設計することができます。

- 指示と文脈を区切るために、「###」のような明確なセパレータを使用することもお勧めされています。

- プロンプトが詳細で説明的であればあるほど、結果は良くなります。

- プロンプトを設計する際には、具体的で直接的であることが重要です。

- やらないことを言うのではなく、代わりにやることを言う。

- 文脈 - 外部情報や追加の文脈を含めることで、モデルがより良い回答に導かれる

- 入力データ - 応答を見つけたい入力や質問

- 出力指標 - 出力のタイプや形式を示す。

より良い結果を得るためのプロンプトの改善させる概念

- Zero-Shot Prompting

- 大量に訓練され調整されたLLMは、命令だけ(ゼロショット)でタスクを実行できる

- Few-Shot Prompting

- より複雑なタスクではゼロショットでは不十分。プロンプトの中でデモンストレーション(例を示す)をおこなうことでモデルの性能を向上させることができる。数発のプロンプトで文脈を使って学習させることができる。

- デモンストレーションで示す入力と結果の分布はどちらも重要

- 一様な分布じゃなく、ランダムな分布でもない場合より有効

- 本当の分布に合わせた分布でデモンストレーションすることでさらなる学習の助けになる

- 推論問題に対してはfew-shotでは不十分。

- より複雑なタスクではゼロショットでは不十分。プロンプトの中でデモンストレーション(例を示す)をおこなうことでモデルの性能を向上させることができる。数発のプロンプトで文脈を使って学習させることができる。

- Chain-of-Thought Prompting(CoT)

dair-ai/Prompt-Engineering-Guide: Guides, papers, lecture, and resources for prompt engineeringの抜粋

- ChatGPTは馬鹿じゃない! 真の実力を解放するプロンプトエンジニアリングの最前線

- Prompt Engineering: The Ultimate Guide 2023 (GPT-3 & ChatGPT)

- LLMがなぜ大事なのか?経営者の視点で考える波の待ち受け方|福島良典 | LayerX

- 大規模言語モデル(LLM)の快進撃

- 自然言語処理AIとの接近 – りん研究室

- GPTの仕組みと限界についての考察(1) - conceptualization

- 深層学習界の大前提Transformerの論文解説! - Qiita

- 数式を使わないTransformerの解説(前編) - conceptualization

- Transformer モデルとは? | NVIDIA

- 【完全保存版】GPT を特定の目的に特化させて扱う (Fine-tuning, Prompt, Index, etc.) - Qiita

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

DB |

docs |

showa |

|

3000 |

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

CAP定理 |

docs |

showa |

|

1 |

ノード間のデータ複製において、同時に次の3つの保証を提供することはできない。

すべてのデータ読み込みにおいて、最新の書き込みデータもしくはエラーのどちらかを受け取る。

ノード障害により生存ノードの機能性は損なわれない。つまり、ダウンしていないノードが常に応答を返す。単一障害点が存在しないことが必要。

システムは任意の通信障害などによるメッセージ損失に対し、継続して動作を行う。通信可能なサーバーが複数のグループに分断されるケース(ネットワーク分断)を指し、1つのハブに全てのサーバーがつながっている場合は、これは発生しない。ただし、そのようなネットワーク設計は単一障害点をもつことになり、可用性が成立しない。RDBではそもそもデータベースを分割しないので、このような障害とは無縁である。

この定理によると、分散システムはこの3つの保証のうち、同時に2つの保証を満たすことはできるが、同時に全てを満たすことはできない。単一障害点があれば、ネットワーク分断が発生した際にシステムがバラバラに分裂しても、そこを基準に一貫した応答ができる(分断耐性+一貫性)が、可用性が成立しなくなる。

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

MySQL |

docs |

showa |

|

1 |

確認

SHOW COLUMNS FROM v_balance;レコード更新のたびに反映

updated[/ at timestamp NOT NULL DEFAULT CURRENT]TIMESTAMP ON UPDATE CURRENT_TIMESTAMPCreate

CREATE OR REPLACE VIEW

[ビュー名]

(

[カラム]

)

AS

SELECT

[カラム]

FROM

[テーブル];MySQL 5.7以前はFrom句にサブクエリを含めることができない

Create

CREATE TRIGGER [トリガー名] [BEFORE|AFTER] [INSERT|UPDATE|DELETE] ON [テーブル]

FOR EACH ROW

BEGIN

...

END;MySQL 5.7以前は2つ以上の処理を含めることができない

確認

SHOW TRIGGERS WHERE `Trigger`='[テーブル名]';Create

CREATE PROCEDURE [プロシージャ名]([引数:in/戻り値:out])

BEGIN

...

END;確認

SHOW PROCEDURE STATUS WHERE Name='[テーブル名]';DDLの動的実行

// sample

SET @ddl = 'ALTER TABLE hogehoge ADD COLUMN hogen int);';

PREPARE ddl_stmt FROM @ddl;

EXECUTE ddl_stmt;

DEALLOCATE PREPARE ddl_stmt;Alter

ALTER TABLE [テーブル名]

PARTITION BY RANGE ([カラム名])

(

PARTITION [パーティション名] VALUES LESS THAN 10000,

PARTITION pmax VALUES LESS THAN MAXVALUE

)確認

SELECT

TABLE_SCHEMA,

TABLE_NAME,

PARTITION_NAME,

PARTITION_METHOD,

PARTITION_EXPRESSION,

PARTITION_DESCRIPTION

FROM

INFORMATION_SCHEMA.PARTITIONS

WHERE

TABLE_NAME = '[テーブル名]';件数とスレッドIDの確認

mysql> SHOW ENGINE INNODB STATUS\Gプロセスの確認

mysql> show processlist;

mysql> KILL {数字};| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

分離性 |

docs |

showa |

|

1 |

同時に実行しても、それぞれのトランザクションを重なりなく順番に実行した場合と同じ結果になることを直列可能(serializable)であると呼びます。

分離性は、この直列可能性を保証するものです。

参考

| title | type | weight |

|---|---|---|

Docker |

docs |

100700 |

Linuxディストリビューションやカーネルのバージョンが違っても動作する理由はいくつかあります。まず、LSB(LinuxStandardBase)はソースコードをコンパイルした時点で、互換性のあるマシンコードを生成するよう、ISO規格として標準化されています。また、LinuxABI(ApplicationBinaryInterface)には、Linuxカーネルのバージョンが上がっても、ユーザー空間で動作するバイナリ(マシンコード)レベルの互換性を維持することが定められています

- ネームスペース(Namespace)

ネームスペースはLinuxのカーネル技術であり、コンテナが1つの独立したサーバーのように振る舞うために使用されます。 - コントロールグループ(cgroup)

cgroupはプロセスに対して、CPU時間やメモリ使用量など、資源の監視と制限を設定することができます

コンテナランタイムの標準仕様「RuntimeSpecificationv1.0」と、コンテナイメージフォーマットの標準仕様「FormatSpecificationv1.0」から成ります。このOCIの定めた標準仕様にしたがいDocker社が実装したのが、コンテナランタイムのrunCです。一方で、CoreOSのコンテナランタイムrktについても、ネイティブで標準に準拠するための作業が進んでいます。

高良真穂.15Stepで習得Dockerから入るKubernetes(Kindleの位置No.909).株式会社リックテレコム.Kindle版.

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Google Cloud |

docs |

showa |

|

4000 |

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Cloud Run |

docs |

showa |

|

1 |

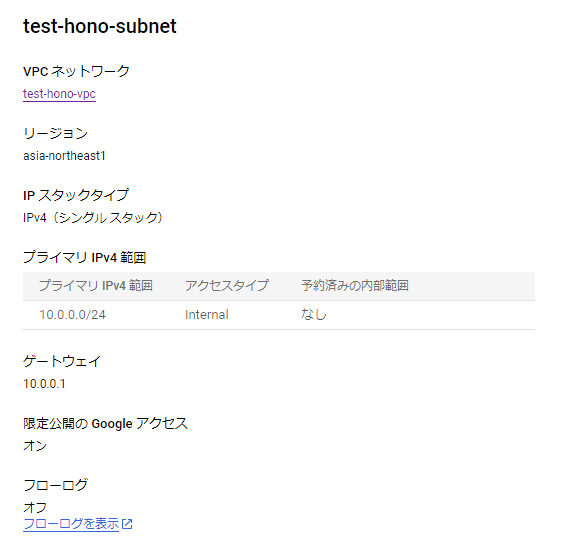

サーバーレス環境でサーバーレスVPCアクセスコネクタ経由で内部DNSと内部IPアドレスを使用してVPCネットワークにリクエストの送信とレスポンスの受信ができる。

反対に他の内部トラフィックをサーバーレス環境に送信する方法については、限定公開のGoogleアクセスを利用する必要がある。

コネクタの IP アドレス範囲を設定するには、次の 2 つの方法がある。

- サブネットを使用するリソースがない場合は、既存の /28 サブネットを指定できる

- 未使用の /28 CIDR 範囲を指定できる

サーバーレス VPC アクセス コネクタは、コネクタ インスタンスで構成されており、マシンタイプが大きいほどスループットが高くなる。

ダイレクトVPCを利用するとサーバーレスVPCアクセスコネクタを使用せずにCloud RunがVPCネットワークに直接トラフィックを送信できる。

また、インスタンスを使用しないためアクセス自体に必要な費用がネットワークの費用だけになる。

ダイレクトVPCで利用すると各インスタンスにサブネット内のIPアドレスが割り当てられるため、サブネット内には十分なIPアドレスが使用可能な状態である必要がある。また、トラフィックが急増したときに備えて事前にIPが割り振られるため、存在するインスタンス数よりも多くなることも留意する。

そのほか制限事項がいくつか存在するため、ドキュメントを参照。

ダイレクトVPCを有効にするとVPC内にCloud Runインスタンスが立ち上がるようになり、Cloud RunからVPC内部のサービスへのリクエストは許可される。一方でVPCのほかのサービスからのCloud Runのインスタンスへのアクセスはできない。

ダイレクトVPCを利用しても、通常通りCloud RunのエンドポイントへのリクエストはCloud Runにルーティングされる。(ここの制御は上り(内向き)の制御でする。)

- VPC ネットワークによるダイレクト VPC 下り(外向き) | Cloud Run のドキュメント | Google Cloud

- Cloud Run でダイレクト VPC 下り(外向き)の提供を開始: パフォーマンス向上と費用削減を実現 | Google Cloud 公式ブログ

デフォルトの設定では、Cloud Runに設定されたドメイン(run.appまたはカスタムドメイン)にインターネット経由でアクセスができる。

上りの設定でこれらのアクセスの制限をかけることができる。

-

内部

以下のソースからのリクエストを許可する。ron.appにアクセスする場合でもGoogleのネットワーク内に閉じる。ほかのソースからのリクエストは到達できない。

Cloud Runなどのサーバレスサービスからのリクエストを内部リクエストとみなすためにはVPCネットワークを経由する必要がある。

→ 限定公開の Google アクセスを構成する | VPC | Google Cloud- 内部アプリケーション ロードバランサ

- VPC Service Controlsの境界内

- Cloud Runと同じプロジェクトまたはVPC Service Controlsの境界内にあるVPCネットワーク

- 共有VPC

- 特定のGoogle Cloudのプロダクト

-

すべて

インターネットから直接run.appへ送信されるリクエストを許可する

内部に設定されたCloud Runにアクセスするには、前述より内部のリクエストにする必要がある。

Cloud Run → Cloud Runにアクセスする場合について考える。

- 内部かつダイレクトVPCのCloud Runにリクエスト

- サーバーレスVPCアクセス経由

この場合、すべてのトラフィックをVPCにルーティングすると内部のリクエストとしてCloud Runに送信される。

一方でプライベートIPのみの場合、Cloud Runにインターネット経由でアクセスするためアクセスできない。 - ダイレクトVPC経由

サーバーレスVPCアクセスでは有効だったすべてのトラフィックを VPC にルーティングに設定してもアクセスができない。

これはダイレクトVPC内にCloud Runを配置するとVPCのほかのサービスからのCloud Runのインスタンスへのアクセスはできないという制約があるためだと考えられる。

そのためダイレクトVPCに設定する場合、必ず限定公開のGoogeleアクセスの設定が必要になる。設定するとちゃんとできる。

プライベート IP へのリクエストのみを VPC にルーティングするの設定のままルーティングさせたい場合は、ドキュメントに記載されたPVCまたは内部ロードバランサーを設定しDNSでそっちを見るようにするか、限定公開のGoogleアクセスを有効にしてDNSを設定するの2通りにのどちらかを選択する必要がある。

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Firebase Emulator on Docker |

docs |

showa |

|

1 |

Docker上でFirebase Emulatorを動かす。備忘録。 ほぼ他所様のブログのまんま。権限の解決だけ追加でやってる。

Firebase Emulatorを動かすDockerfileの内容は以下の通り。

cli-tableの不具合によって、firebase-toolsのv9.22.0で動作しなくなっていたため、暫定対処としてgithubからcloneして、cli-tableのバージョンをバグのないバージョンに固定している。が、11/18にマージされていて解決している。

Firebase Emulator throws npm cli-table error only when importing firestore data · Issue #3909 · firebase/firebase-tools

FROM node:16-alpine

RUN apk add --no-cache openjdk11-jre-headless \

&& apk add shadow

# && apk add shadow \

# && apk add git

RUN npm i -g firebase-tools

#11/18に不具合対応がマージされてv9.23.0で解決

#cli-tableにバグがあり、暫定対応のために

#firebase-toolsのcli-tableのバージョンを固定してbuildしている

#RUN mkdir tools && cd tools \

# && git clone https://github.com/firebase/firebase-tools.git -b v9.22.0 \

# && cd firebase-tools \

# && npm install -g npm \

# && npm config set save-exact true \

# && npm install cli-table@0.3.6 \

# && npm install \

# && npm run build \

# && npm link

RUN groupmod -g 1000 node && usermod -u 1000 -g 1000 node

USER node

以下Docker Composeのファイル。

ホスト側のfirebaseのキャッシュや設定を直接読み取って起動している。

ただ、ホスト側でemulatorを起動していると、権限が異なるためPermission deniedになる。

これを回避するために、ホスト側と同じグループのユーザーをDockerfileで設定している。

version: '3'

services:

firebase:

build:

context: .

dockerfile: firebase/Dockerfile

tty: true

restart: always

command: firebase emulators:start --only auth,firestore --export-on-exit ./firebase/.firebase --import ./firebase/.firebase

ports:

- "9000:9000"

- "8080:8080"

- "9099:9099"

volumes:

- .:/workspace

- ~/.cache/firebase:/root/.cache/firebase

- ~/.config/configstore:/root/.config/configstore

working_dir: /workspace

権限周りなんもわからん

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Link |

docs |

showa |

|

10000 |

| title | type | lastmod | waight | |

|---|---|---|---|---|

GitHub Actions |

docs |

|

1 |

continue-on-error

trueが設定されているステップでエラーになっても後続のステップの動作が継続される。

変更があるときだけコミット [GitHub Actions]

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Command |

docs |

showa |

|

1 |

go.modファイルにあるモジュールの依存関係を更新し、パッケージをビルドしてインストールする。 モジュールとバージョンが解決できたら、require命令を追加、変更、削除する。 go.modのrequireディレクティブの管理に重点を置いている。

go get

# a specific module

# 暗黙的に@upgrade queryが使われる

# go get -d golang.org/x/net@upgrade

go get -d golang.org/x/net

# all modules

go get -d -u ./...

go get -d -u all

# a specific version

go get -d golang.org/x/text@v0.3.2

# a specific branch name or revision

go get -d golang.org/x/text@master

# @none suffixでモジュールの削除ができる

go get golang.org/x/text@none-d- ビルドやインストールを行わないように指示する

-dなしでgo getを使うことは非推奨です。- Go1.18からデフォルトで有効になる

-u- パッケージからインポートされたパッケージを提供するモジュールをアップグレードするように指示する

-u=patch- 最新のパッチバージョンにアップグレードする

-t- 指定されたパッケージのテストを動作させるために必要なモジュールも含めるように指示する

-insecurehttpのような安全でないスキーマから取得することを許可する- 非推奨

パッケージをビルドしてインストールする。実行ファイルは$GOBINで指定されたディレクトリにインストールされる。$GOROOTにある実行可能ファイルは$GOBINではなく、$GOROOT/binまたは$GOTOOLDIRにインストールされる。

Go1.16以降、引数にバージョンのさフィクスがある場合、モジュールを考慮したモードでパッケージをビルドする。このとき、カレントディレクトリや親のディレクトリにgo.modがある場合、go.modを無視する。

go install

# go install [build flags] [packages]mフラグでモジュールをリストアップする。

go list -m

# go list -m [-u] [-retracted] [-versions] [list flags] [modules]

go list -m all

go list -m -versions example.com/m

go list -m -json example.com/m@latest-f- フラグでフォーマットテンプレートを適用する。

-u- 利用可の名アップグレードに関する情報を追加する

-versions- そのモジュールのすべての既知のバージョンをセマンティックバージョニングに従って順番にリストアップする

retractedフラグが指定されない場合、撤回されたバージョンは一覧から省かれます

指定されたモジュールをモジュールキャッシュにダウンロードします。

引数なしの場合、メインモジュールのすべての依存関係を適用される。

goコマンドは必要に応じて自動的にモジュールをダウンロードします。モジュールキャッシュの事前ロードやプロキシが提供されるデータのロードに有用。

go mod download

# go mod download [-json] [-x] [modules]

go mod download

go mod download golang.org/x/mod@v0.2.0-json

ダウンロードされた各モジュールについてのJSONオブジェクトを標準出力に出力する-x

ダウンロードが実行するコマンドを標準エラーに出力する

go.modファイルの編集や書式設定のためのインターフェース。

go mod edit

# go mod edit [editing flags] [-fmt|-print|-json] [go.mod]

go mod edit -replace example.com/a@v1.0.0=./a

go mod edit -json-

-modulego.modファイルのモジュールの行を変更する -

-go=version動作に期待するGoのバージョンをセット -

-require=path@version与えられたモジュールをrequireディレクティブに追加・削除- 記載の上書きを行うだけなので、必要な変更をおこなう

go getを利用すべき

- 記載の上書きを行うだけなので、必要な変更をおこなう

-

exclude=path@versionexcludeディレクティブに追加・削除をおこなう -

-replace=old=new与えられたペアのreplaceディレクティブに追加する -

-dropreplace=old与えられたモジュールパスのreplaceディレクティブをドロップする -

retract=versiondropretract=versionretractディレクティブに追加・削除をおこなう。ただしコメントは記載できない -

出力方法の操作

-fmt他の変更を加えずにgo.modファイルの再フォーマットをおこなう。ほかのフラグが指定されていない場合にだけ利用できる-printgo.modへの書き込みをする代わりに標準出力する-jsongo.modへの書き込みをする代わりにjson形式で標準出力する

replace適用後のrequireディレクティブのテキスト形式を表示する。

各行はモジュールのバージョンと依存関係をもつグラフのエッジを表現する。

go mod graph

# go mod raph [-go=version]カレントディレクトリに新しいgo.modファイルを初期化して書き込む。

vendoringツールの設定ファイルが存在する場合、その設定ファイルからモジュールディレクティブをインポートする。

go mod init

# go mod init [module-path]| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Generics |

docs |

showa |

|

1 |

関数のパラメータはgo1.17以前ではパラメータの型によって制限された値の集合の範囲にあった。go1.18でジェネリクスが導入され、関数や型は型パラメータをもつことができるようになった。型パラメータによって、関数のパラメータや型が満たすべき型の制約(性質)を定義できるようになった。

型パラメータはインターフェース型で型のセットを定義できる。ジェネリクスの導入によってインターフェース型はメソッドの集合という定義から型の集合を定義するように仕様が変更された。この変更によって以前はメソッドによって間接的に型を制限していたが、明示的に型の集合を定義できるようになった。

go1.18より前と異なり、インターフェース型を実装するというのはインターフェース型でない型Tの場合、満たすべきインターフェース型が定義する型集合の要素であることが必要である。型Tがインターフェース型である場合、満たすべきインターフェース型が定義する型集合の部分集合であれば実装している。

| 集合 | 型 | 説明 |

|---|---|---|

| 任意の型 | interface { AnyType } | 任意の型の集合 |

| 型の和集合 | interface { int | string } | 複数の型の和集合 型制約としてしか利用できない メソッドをもつインターフェース型では利用できない |

| 基底型 | interface { ~int64 | ~float64 } | 基底型を満たす型の集合 |

基本的な型制約はconstraintsパッケージで提供される。

型制約は型パラメータが許容する型を指定するものだけでなく、型パラメータが可能な操作を定義します。メソッドセットで定義された関数や+や*のような算術演算やビット演算なども型パラメータによって許可される。

演算とは異なり、等式など比較が可能かどうかの型制約はcomparableの型集合によって定義される。

ただし、comparableによる型集合と言語仕様の型の集合(spec-comparable)は同等ではない。anyなどのインターフェースで実際の値がcomparableでない場合、比較時にruntime panicが発生します。comparableには比較時にパニックをおこさないことを保証している型だけが含まれます。このような型をstrictly comparableと呼ぶ。

go1.20からstrictly comparableでなかったany型もcomparableとして扱えるようにcomparableはインターフェースの実装(implement comparable)と型引数を型パラメータにわたすときの制約充足(satisfy comparable)を区別するようになった。つまり、implement comparableがstrictly comparableを満たし、satisfy comparableがspec-comparableを満たすようになります。

以下の例を考える。

func f[T comparable](x, y T) {

if x == y { // (4)

fmt.Println("Same!!!")

}

}

func g[P any]() {

_ = f[int] // (1)

_ = f[P] // (2)

_ = f[any] // (3)

}3番目のケースではany型は空のインターフェースなのでcomparableを満たす(satisfy comparable)。ただし、any型はcomparableを実装しないので、comparableでない値を引数に渡した場合、(4)でruntime panicが発生します。これはimplement comparableと区別されたことで厳密な型安全性をもたなくなったためである。

2番めのケースではP型はany型で制約されたパラメータなので、すべてのパラメータがcomparableを満たさないので、comparableを満たさない。

型推論に成功したら、インスタンス化がおこなわれる。インスタンス化は型パラメータに実際に型推論された型パラメータを代入した型がインスタンス化される。そのため、型に定義されたメソッドは型のインスタンスが生成された時点で確定するため、個別のメソッドがジェネリクスによる型推論によるインスタンス化をおこなうことはできない。

以上が自分の理解。

[Go言語のジェネリクス入門(1) https://zenn.dev/nobishii/articles/type_param_intro] [Go言語のジェネリクス入門(2) インスタンス化と型推論 https://zenn.dev/nobishii/articles/type_param_intro_2] [Go言語のBasic Interfaceはcomparableを満たすようになる(でも実装するようにはならない) https://zenn.dev/nobishii/articles/basic-interface-is-comparable] [All your comparable types - The Go Programming Language https://go.dev/blog/comparable] [Core Types | The Go Programming Language Specification - The Go Programming Language https://go.dev/ref/spec#Core_types]

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Go Genericsで実装するYコンビネータ |

docs |

showa |

|

1 |

元はこれ

実装の自己理解のためのメモ

https://go.dev/play/p/15_CYMMp4Pk

| title | type | weight | lastmod | |

|---|---|---|---|---|

Links |

docs |

100000 |

|

- (26) Internals of Maps in Golang - YouTube

builtinのmapのデータ構造に関する説明

- Workiva/go-datastructures: A collection of useful, performant, and threadsafe Go datastructures.

Goでつくられたデータ構造のリポジトリ - Finding The Best Go Project Structure — Part 1 | by Aviv Carmi | May, 2023 | ITNEXT

- Goのパッケージ構成について

- Organizing a Go module - The Go Programming Language

- ついにディレクトリ構成の公式発表

- レイヤードアーキテクチャとかクリーンアーキテクチャとか

- Home · golang/go Wiki

- Effective Go - The Go Programming Language

- Go by Example

- avelino/awesome-go: A curated list of awesome Go frameworks, libraries and software

- pion/example-webrtc-applications: Examples of WebRTC applications that are large, or use 3rd party libraries

- SimonWaldherr/golang-examples: Go(lang) examples - (explain the basics of #golang)

- Common Anti-Patterns in Go Web Applications

- Implementing Go stream API. What is Stream Processing | by Kevin Wan | Dev Genius

- Behind the Scenes of Go Scheduler - DEV Community

- What is the zero value, and why is it useful? | Dave Cheney

- A complete guide to working with Cookies in Go – Alex Edwards

- 100 Go Mistakes

- start fast: booting go programs quickly with

inittraceandnonblocking[T]- 起動時間の高速化をはかる記事

- Handling network bursts with channels in Golang :: Yoshiyuki Kurauchi — A telecom / networking / security enthusiast.

- Concurrent HTTP Requests in Golang: Best Practices and Techniques | by Rafet Topcu | Insider Engineering | Jan, 2024 | Medium

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

lru |

docs |

showa |

|

1 |

かんたんにじっそうした。連結リストとハッシュマップの組み合わせ。追加で取得時に生存期間チェックして超過してたらキャッシュから消してる。

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Modules |

docs |

showa |

|

1 |

モジュールは、リリース、バージョン管理や配布されるパッケージの集合。

モジュールパスによって識別され、Moduleの依存関係の情報とともにgo.modで宣言される。

go.modファイルを含むディレクトリがモジュールのルートディレクトリとなります。

モジュール内の各パッケージは同じディレクトリにあるソースファイルをまとめてコンパイルしたもの

- パッケージのパスはモジュールのパスにパッケージを含むモジュールルートからの相対パス。

- リポジトリのルートパスは、バージョン管理リポジトリのルートディレクトリに対応する

- パス構成

- リポジトリのルートパス/ディレクトリ/メジャーバージョンサフィックス

- メジャーバージョンサフィックス

- メジャーバージョン2以上の場合つける

- 必ずしもサブディレクトリの名前の一部である必要はない

- メジャーバージョンサフィックス

- リポジトリのルートパス/ディレクトリ/メジャーバージョンサフィックス

セマンティックバージョンで管理 v{メジャー}.{マイナー}.{パッチ}

また、オプションで以下の2つをつけられる

- ハイフンで始まるプレリリース文字列

- プラスで始まるビルドメタタグ文字列

v1.2.3-pre

v1.2.3+meta

v1.2.3+imcompatible

バージョンアップについて

- メジャーバージョン

- 後方互換性がない変更がされた場合

- パケージ削除や、インターフェースの変更など

- 推移的依存関係により2つの異なるバージョンが必要とされる場合、より高いバージョンが利用される

- v2以降は、モジュールのパスに

/v2のようなサフィックスが必要- 1つのビルド内で複数のメジャーバージョンが利用される場合がある

- 常に最新を利用する場合、バージョン間に互換性がない場合、依存しているモジュールが動かない場合があるため。

- マイナーバージョン

- 後方互換性がある変更がされた場合

- 関数が追加されたなど

- パッチバージョン

- バグフィックスや最適化された場合などインターフェースに影響が与えない場合

- pre-releaseサフィックス

- あるバージョンをプレリリースであることを示す

- プレリリースバージョンはリリースバージョンの前になる

- ビルドメタデータ接尾辞

- バージョン比較では無視される

- go.modファイルでは保持

- imcompatible接尾辞

- モジュールバージョンのメジャーバージョンに移行する前にリリースされたバージョン

- メジャーバージョンが2以上のgo.modファイルのないリポジトリとの互換性のためのサフィックス

- 作成者が自分でつけるものではなく、goコマンドが判断して付与されるサフィックス

バージョン管理リポジトリの特定のリビジョンの特別な書式のプレリリースバージョン

バージョンタグが利用できないリビジョンの参照で利用される

vX0.0-{リビジョンが作られたUTC時間}-{コミットハッシュの12文字}

パッケージパスの接頭辞を持つモジュールをビルドリストからから検索する。

ビルドリストにある場合、ディレクトリにパッケージを含んでいるかチェックする。

ビルドリストの中で1つのモジュールがパッケージを提供していなかったり、2つ以上のモジュールが同じパッケージを提供しているとエラーになる。

go build -mod=modでコンパイルをおこなうと不足しているパッケージを提供するモジュールを探す。

go getとgo mod tidyはこれを行う。

パッケージパスのモジュールを探すときにGOPROXYを調べる。

GOPROXYリストの各エントリに対して、パッケージパスのプレフィックスの最新版を要求する。要求に成功したら、そのモジュールをダウンロードし必要なパッケージが含まれているか検証する。1つ以上のモジュールがパッケージを含んでいる場合、最も長いパスをもつモジュールを使用する。ただし、パッケージが見つからない場合はエラー。

解決されたモジュールはgo.modファイルに追加される。

メインモジュールで利用されていない場合、// indirect commentのコメントをもつ。

GOPROXY:カンマ区切りのプロキシURLのリスト、direct、off

ルートディレクトリに行志向で記述されるUTF-8でエンコードされたファイル。

-

go get:依存関係のアップグレード、ダウングレードが可能 -

go mod edit:より低レベルな編集が可能 -

golang.org/x/mod/modfile:プログラム的にmodファイルを変更できる -

moduleディレクティブ:メインモジュールのパスを定義する。modファイルに1つ必ず含める。

ModuleDirective = "module" ( ModulePath | "(" newline ModulePath newline ")" ) newline .- module fuga

-

Deprecated:moduleディレクティブの前か後で、コメントブロックの中で非推奨をマークできる。

// Depecated: comment- そのモジュールのすべてのマイナーバージョンで適用される。v2より高いメジャーバージョンは別モジュール扱いとなる。

- Go1.17以降、

go list -m -uはビルドリストにあるすべての非推奨モジュールをチェックする。go getはコマンドラインで指定されたパッケージをビルドするために必要な非推奨モジュールをチェックする。

-

goディレクティブ:モジュールが期待するGoのセマンティックバージョンを記載する。

- go.modファイルの中に、最大で1つ含めることができる

- 後方互換性のない変更をサポートするためのものだった

- 指定されたバージョンよりあとに導入された言語機能の使用ができないようにする

- goコマンドの動作が変更される

- go1.14以降

vendor/modules.txtファイルが存在すると、自動ベンダリングが有効になる

- go1.16以降

- mainモジュールでimportされたパッケージとテストでインポートされたものだけにマッチ する

- より低いgoのバージョンでは、メインモジュールのパッケージによってインポートされたパッケージも含んでいた

- go.modファイルがないパッケージを読み込んだ場合、間接的な依存関係が発生する

- go1.17以降

- go.modファイルに、モジュールのパッケージやテストでインポートされるパッケージで利用される間接的に必要なモジュールも明示的にrequireに含まれるようになる

- importしたモジュールとして必要なモジュールであったとしても、パッケージで利用されていない場合、読み込む必要がないため、刈り込みの対象になる。

- モジュールグラフの刈り込みやモジュールの遅延読み込みが可能になる

- ※1.16以下では間接的な依存関係は最小限のバージョンしか含まれなかった

- 間接的な依存関係(

//indirect)が存在する可能性があるため、go.modファイル内の別のブロックに記載される go mod vendorはgo.modとgo.sumを省略する- 依存しているモジュールそれぞれのgo.modファイルから

vendor/module.txtにgoのバージョンを記録する

- 依存しているモジュールそれぞれのgo.modファイルから

- go.modファイルに、モジュールのパッケージやテストでインポートされるパッケージで利用される間接的に必要なモジュールも明示的にrequireに含まれるようになる

- go1.14以降

-

requireディレクティブ

- 依存モジュールの中で最小の必須のバージョン(MVS)を選択し定義される

// indirectコメントがある場合、モジュールが直接依存していないモジュールを表す- go 1.16以下

- メインモジュールの依存で利用されているモジュールのバージョンより高いバージョンの場合、indirectとして追加する

go get -uによる明示的なアップグレードや、依存関係の削除、go.modを持たないパッケージをインポートする場合に発生する

- go 1.17以降

- メインモジュールのテストやパッケージなどによって(間接的にでも)importされたそれぞれのパッケージも間接的な要件として追加される。

- これによって、go.modの再帰読み込みが最小限になり、モジュールグラフの刈り込みやモジュールの遅延読み込みが可能になる

- go 1.16以下

-

excludeディレクティブ

- 指定のモジュールのあるバージョンがgoコマンドでロードされるのを防ぐ

- メインモジュールのgo.modファイルだけで適用される

- go 1.16以前

- requireディレクティブで参照されているバージョンがメインモジュールのexcludeディレクティブで除外されている場合、利用可能なバージョンをリストアップし(go list -m -versions)代わりに除外されていないより高いバージョンをロードする。

- 時間経過で変化する可能性があります。

- 高いバージョンがない場合、エラーを出力する

- go 1.16以降

- requireディレクティブで参照されているバージョンがメインモジュールのexcludeディレクティブで除外されている場合、requireは無視されます。

- go getやgo mod tidyなどでより高いバージョンをinderectでで追加する要因になる

exclude golang.org/x/net v1.2.3

exclude (

golang.org/x/crypto v1.4.5

golang.org/x/text v1.6.7

)- replaceディレクティブ

- あるモジュールの特定のバージョン、またはすべてのバージョンを他の内容に置き換える

- メインモジュールのgo.modファイルだけで適用される

- 別のモジュールのパス、またはプラットフォーム固有のファイルパスを指定する

- 矢印の左側にバージョンがある場合、そのバージョンだけ置換される

- 矢印の右側が絶対パスや相対パスの場合、ローカルのファイルパスとして解釈される

- 置換後のバージョンは省略する

- 矢印の右側がローカルパス出ない場合、モジュールパスでなければならない

- 置換後のバージョンは必須

replace golang.org/x/net v1.2.3 => example.com/fork/net v1.4.5

replace (

golang.org/x/net v1.2.3 => example.com/fork/net v1.4.5

golang.org/x/net => example.com/fork/net v1.4.5

golang.org/x/net v1.2.3 => ./fork/net

golang.org/x/net => ./fork/net

)- retractディレクティブ(Go 1.16以降)

- go.modで定義されたモジュールのバージョンや範囲が利用されるべきでないことを示す

- リリースが早かった場合や、深刻な不具合が見つかった場合に利用する

- retractされても依存されたモジュールのビルドが壊れないように利用可能なままにすべき

- retractの根拠を説明するコメントを持つべきだが、必須ではない

- 撤回するにはretractを含んだ最新のバージョンを公開する必要がある(@latestで解決できるようにする)

- retractで撤回されるとgo getやgo mod tidyで自動的にそのバージョンにアップグレードすることはなくなる

- go getやgo list -m -uで更新をチェックすると通知される

- go list -m -retractedでないとバージョンリストからは隠される

- go.modで定義されたモジュールのバージョンや範囲が利用されるべきでないことを示す

retract v1.0.0

retract [v1.0.0, v1.9.9]

retract (

v1.0.0 // Published accidentally.

[v1.0.0, v1.9.9]

)White Space:スペース、タブ、キャリッジリターン、ニューリターンComments://,/* */がコメントとして許容されているPunctuation:,や=>が句読点Keywords:module、go、require、replace、exclude、retractIdentifiers:モジュールパスやセマンティックバージョンなどの並びStrings:"",\``で囲まれた文字の並びを文字列とする

- パスは1つ以上のスラッシュで区切られている必要がある

- また、文頭と文末がスラッシュになってはいけない

- ASCII文字、ASCII数字、制限付きASCII句読点からなるからでない文字列であること

- パス要素はドットから始まったり終わったりしてはいけない

- 最初のドットまでの要素名はWindwsの予約語であってはならない

- 最初のドットまでの要素名はチルダに続く1桁以上の数字で終わってはいけない

モジュールパスがrequireに含まれていてreplaceされていない場合、またはモジュールパスがreplace命令の右側にある場合、そのパスでダウンロードする必要があり、次の要件を満たす必要がある。

- 最初のスラッシュまでの先頭のパス要素は慣習的にドメイン名であり、少なくとも1つ以上のドットを含む必要があり、ダッシュ(

-)から初めてはならない。 - パス要素の末尾が

/vN(Nは数字とドット)である場合、- Nの先頭文字が0であってはならない

/v1であってもならない- ドットを含んではならない

go.modに情報が欠けたり、実態と異なっているとエラーになる。

go get やgo mod tidy、または-mod=modフラグはこれらの問題を自動で修正する。

go1.15以下では-mod=modが有効になっておりgoコマンドで自動実行されていた。

go1.16以降では-mod=readonlyが設定されているように動作する。go.modへの変更が必要な場合、エラーを報告する。

GOPATHからの移行の保証のために、goコマンドでgo.modを追加することでモジュールに移行していないリポジトリもモジュールのリポジトリに移行が可能。

go.modファイルのないモジュールをダウンロードする場合、goコマンドはモジュールディレクティブ以外なにもないモジュールキャッシュにあるgo.modファイルを統合します。

統合されたgo.modファイルにはgo.modファイルのないモジュールの依存関係をあらわすrequireディレクティブをもたないので、それぞれの依存関係が同じバージョンでビルドできることを保証するために、追加のreuireディレクティブ(// require)を必要とします。

詳細はRus Cox著のresearch!rsc: Minimal Version Selection (Go & Versioning, Part 4)

GoはMVSというアルゴリズムを使用してパッケージを構築するモジュールのバージョンを選択する。

MVSはビルドで使用されるモジュールのバージョンのリストであるビルドリストを出力として生成する。各モジュールで必要なバージョンを追跡しながらグラフを横断する。グラフをすべて巡回した時点で最も要求の高いバージョンでリストが構築される。このリストがすべての要求を満たす最小のバージョン。

go list -m allで確認できる。ビルドリストは決定論的に決まっているので、新しいバージョンの依存関係がでても変更されない。

モジュールの内容は、メインモジュールのgo.modファイルにあるreplaceディレクティブを使用して置き換えられる。置換されたモジュールは、置換前と異なる依存関係を持つ可能性があるため、モジュールグラフが変化する。

モジュールの内容は、メインモジュールのgo.modファイルにあるexcludeディレクティブで特定のバージョンをモジュールから除外できる。除外されるとモジュールグラフから除外されるため、上位のバージョンの要求に置き換えられる。

go getコマンドでモジュールのアップグレードするために使用される場合、MVSを実行する前にモジュールグラフを変更して、アップグレードされたバージョンのエッジを追加する。

ダウングレードする場合、ダウングレードするバージョンより上のバージョンをモジュールグラフから削除することでモジュールグラフの変更を行います。削除されたバージョンに依存する他のモジュールのバージョンの情報も削除されます。

また、メインモジュールがダウングレードによって削除されたバージョンを要求している場合、削除されたバージョンより前のバージョンを要求するモジュールのバージョンに変更されます。

メインモジュールがgo1.17以上の場合、MVSで使われるモジュールグラフには、go1.16以下のモジュールの依存関係で要求されない限り、go.modファイルでgo1.17以上が指定されている各モジュールの依存関係の直接的な要件のみ含まれる。(推移的依存関係はグラフから切り捨てられる。)

go1.17のgo.modファイルからは、そのモジュールのパッケージやテストをビルドするために必要なすべての依存関係のためのrequireディレクティブを含む。(明示的に必要でない依存関係はモジュールグラフから刈り取られる)

あるモジュールにとって必要のないモジュールは動作に影響を与えることはできないので、モジュールグラフで刈り取られた依存関係が残っていると無関係なモジュール間の干渉を引き起こす。

go1.16以前はgo.modファイルに直接の依存関係しか含まれていなかったため、より大きなすべての間接的な依存関係がロードされないといけなかった。

go mod tidyによって記録されたgo.sumは、go.modのgoディレクティブより1つ下のバージョンで必要なチェックサムを含む。

go1.17では、go1.16でロードされた完全なモジュールグラフに必要なチェックサムをすべて含む。

go1.18では、go1.17で刈り取られたモジュールグラフで必要なチェックサムだけを含む。

メインモジュールがgo1.17以降の場合、モジュールグラフ全体の読み込みを必要になるまで遅延させられる。代わりにメインモジュールのgo.modファイルのみを読み込んで、その要件だけをつかってビルドするパッケージのロードを試みる。メインモジュール外のパッケージのテストの依存などで必要なパッケージが見つからない場合、残りのモジュールグラフを要求に応じてロードする。

モジュールグラフを読み込まずにgo.modファイルからインポートされたパッケージが全て見つかった場合、go.modファイルをロードする。ロードした結果、メインモジュールの要件と照合されてローカルで整合していることが確認される。

ワークスペースはMVSを実行するときに、ルートモジュールとして使用されるディスク上のモジュールの集合です。

ワークスペース各モジュールのディレクトリへの相対パスを指定したgo.workファイルで宣言できる。go.workが存在しない場合、ワークスペースはカレントディレクトリを含む単一のモジュールで構成される。

-workfileフラグを確認することで、ワークスペースのコンテキスト上にあるかを判断する。フラグは.workで終わる既存のファイルへのパスを指定した場合、有効化される。

ルートディレクトリに行志向で記述されるUTF-8でエンコードされたファイル。

go 1.18

use ./my/first/thing

use ./my/second/thing

use (

./my/first/thing

./my/second/thing

)

replace example.com/bad/thing v1.4.5 => example.com/good/thing v1.4.5

- goディレクティブ

- go.workファイルに必須

- 有効なリリースバージョンを記載

- useディレクティブ

- ディスク上のモジュールをワークスペースのメインモジュールの集合に追加する。

- go.modファイルがあるディレクトリの相対パス

- replaceディレクティブ

- go.modのreplaceディレクティブと同様にすべて、もしくは特定のバージョンのモジュールの内容を置き換える

- go.workのワイルドカードの置換は、go.modファイルのバージョン指定のreplaceをすべて置き換える

goコマンドはモジュール対応モードとGOPATHモードで実行できる。

- GO111MODULE=off

- go.modファイルがあってもGOPATHモードで実行される

- GO111MODULE=on

- go.modファイルの存在有無に関わらずモジュールモードで動作する

- go.modファイルを使って依存関係を探すようになります

- go1.16以降ではデフォルトで有効

- GO111MODULE=auto

- go1.15以前でデフォルトで有効

- go.modファイルがあるとモジュールモードが有効化される

go build, go fix, go generate, go get, go install, go list, go run, go test, go vet

モジュールコマンドに共通する以下のフラグを利用できる

-mod

go.modが自動的に更新されるか、vendorディレクトリが使われるかを制御するgo1.14 以上ではvendorディレクトリが存在する場合、-mod=vendorを指定されたように動作する。そうでない場合、mod=readonlyが指定されたように動作する。

-mod=mod- vendorディレクトリを無視してgo.modを更新するように指示する

-mod=readonly- vendorディレクトリを無視してgo.modを更新が必要な場合、エラーを報告する

-mod=vendor- vendorディレクトリを利用するように指示する

-moodcacherwモジュールキャッシュに作成するディレクトリを書き込みも可能なパーミッションを指定する。 パーミッションを変更せずにモジュールキャッシュを削除できる-modfile=file.modモジュールルートディレクトリのgo.modファイルの代わりのファイルを読み書きするように指定できる。拡張子は.modである必要がある。ただし、go.modファイルはモジュールルートディレクトリを決めるために必要だが、使用されることはない。-workfileワークスペースを定義するgo.workファイルを使用してワークスペースモードを使用するようにgoコマンドに指示する。

- vendorディレクトリを利用するように指示する

go mod vendorコマンドでメインモジュールのルートディレクトリにvendorディレクトリを作成。メインモジュールのパッケージのビルドやテストに必要なすべてのパッケージのコピーを格納する。メインモジュール以外のパッケージのテストでしか使われていないパッケージは含まれない。

また、vendor/modules.txtというファイルが作成される。vendoringが有効な場合、go list -mなどで出力されるバージョン情報のソースとして使用される。このとき、modules.txtはgo.modファイルと一致するかどうかチェックする。

go1.14以上でメインモジュールのルートディレクトリにvendorディレクトリがあれば自動で使用される。

vendorが使用される場合、ビルドコマンドはネットワークやモジュールキャッシュにアクセスせずにvendorディレクトリからパッケージをロードする。

| title | type | weight | lastmod | |

|---|---|---|---|---|

Release |

docs |

1 |

|

2023/8リリース

- このマイナーバージョンから

.0のパッチバージョンがつくようになった - buildin関数が増えるよ

- min/max

- clear

mapがデカくなっちゃったままにはならんのかな

- 型推論のパワーアップ

- ジェネリックな関数の引数としてジェネリックな関数を渡した場合、型引数をわたさなくても関数側の引数の型から型推論されるようになった。

go:wasmimportディレクティブでWebAssemblyからインポートした関数をGoのプログラムで利用できるようになった- ようわからん

- WASIの対応を実験的にはじめた

- 1.20ではいったPGOがbuildコマンドのpgoフラグがデフォルトで

-pgo=autoになった。 - 追加された関数

log/slogパッケージ正式リリース- slogハンドラーのテスト用に

testing/slogtestが追加

- slogハンドラーのテスト用に

- スライスやマップの共通の関数をまとめた

slices,mapsパッケージが追加- これがジェネリクスの賜物なんだな。

contextWithoutCancel:キャンセルされたコンテキストからキャンセル前のコンテキストのコピーを返す。WithValueとかしたやつもコピーされるのかな。WithDeadlineCause/WithTimeoutCause:タイマー切れのときに原因を設定できるようになる。Cause関数で取得できるAfterFunc:コンテキストがキャンセルされた後に実行する関数を登録できる- cleanup関数登録とかすんのかな

- カバレッジのプロファイルをコンパイル後のバイナリの実行で取得できるようになった

Coverage profiling support for integration tests - The Go Programming Language

go build -coverでカバレッジのプロファイルを出力するバイナリにビルドできる。-covevrpkgフラグでカバレッジに含めるパッケージを指定できる。プロフィルが環境変数COVERDIRで指定されたディレクトリに出力される。環境変数COVERDIRのプロファイルを操作するgo tool covdataが追加go tool covdata percent -i=somedataでカバレッジの割合が出力されるgo tool covdata textfmt -i=somedata -o profile.txtでgo testで生成されるプロファイルに変換go tool covdata merge -i=windows_datadir,macos_datadir -o mergedで複数のOSで実行したプロファイルのマージができる

- プロファイル誘導型最適化(PGO)

Profile-guided optimization - The Go Programming Language

CPU pprofファイルをコンパイラのフィードバックとして使用しコンパイラの最適化の決定(FDO)をおこないます。PGOを使用してビルドすると性能が2~4%程度の向上が期待できるコンパイル時のコードが取得したプロファイルのコードから変更されていた場合、変更箇所は最適化の影響をうけない。コンパイラはPGOビルドを繰り返しても最適化のばらつきを防ぐような保守的なつくりになっている。

go build -pgo=autoでビルドするとdefault.pgoファイルを自動で選択してコンパイルします。go1.20ではデフォルトでgo build -pgo=off

- slice型を配列のポインタにキャストできるようになった

型変換でパニックを起こす可能性がある。 - go.modに間接的に呼び出されるパッケージが含まれるようになった

go get時とかにサブパッケージのgo.modまで読み込む必要がなくなったのかな // +buildだったのが、他に合わせて//go:buildに変更されたgo runでバージョンサフィックス付きで呼び出せるようになった

go run example.com/hoge/cmd@v1.0.0

ファイルをインストールしたり、go.modに変更を及ぼさずに使える- tools.goいらない子。

- コンパイラが関数の引数にレジストリ使うようになって2%処理速度が向上

- testing.Tとtesting.BにSetenvが追加

テストに閉じた環境変数を設定できる

| package main | |

| import ( | |

| "fmt" | |

| "sync" | |

| "sync/atomic" | |

| "time" | |

| ) | |

| const CacheLinePadSize = 64 | |

| type CacheLinePad struct { | |

| _ [CacheLinePadSize]byte | |

| } | |

| type RingBuffer[T any] struct { | |

| size uint64 | |

| buf []T | |

| _ CacheLinePad | |

| readIndex atomic.Uint64 | |

| cachedWriteIndex uint64 | |

| _ CacheLinePad | |

| writeIndex atomic.Uint64 | |

| cachedReadIndex uint64 | |

| } | |

| func NewRingBuffer[T any](n int) *RingBuffer[T] { | |

| size := uint64(2 << (n - 1)) | |

| return &RingBuffer[T]{ | |

| buf: make([]T, size), | |

| size: size, | |

| } | |

| } | |

| func (r *RingBuffer[T]) Dequeue() (item T, ok bool) { | |

| readIndex := r.readIndex.Load() | |

| if readIndex == r.cachedWriteIndex { | |

| r.cachedWriteIndex = r.writeIndex.Load() | |

| if readIndex == r.cachedWriteIndex { | |

| return | |

| } | |

| } | |

| item = r.buf[readIndex&(r.size-1)] | |

| r.readIndex.Store(readIndex + 1) | |

| return item, true | |

| } | |

| func (r *RingBuffer[T]) Enqueue(item T) bool { | |

| writeIndex := r.writeIndex.Load() | |

| if writeIndex-r.cachedReadIndex == r.size { | |

| r.cachedReadIndex = r.readIndex.Load() | |

| if writeIndex-r.cachedReadIndex == r.size { | |

| return false | |

| } | |

| } | |

| r.buf[writeIndex&(r.size-1)] = item | |

| r.writeIndex.Store(writeIndex + 1) | |

| return true | |

| } | |

| func main() { | |

| rb := NewRingBuffer[int](10) | |

| size := 2 << 9 | |

| var wg sync.WaitGroup | |

| start := time.Now() | |

| for i := 0; i < 1024; i++ { | |

| wg.Add(2) | |

| go func() { | |

| defer wg.Done() | |

| for i := 0; i < size; i++ { | |

| for { | |

| if ok := rb.Enqueue(i); ok { | |

| break | |

| } | |

| } | |

| } | |

| }() | |

| go func() { | |

| defer wg.Done() | |

| for i := 0; i < size; i++ { | |

| for { | |

| if _, ok := rb.Dequeue(); ok { | |

| break | |

| } | |

| } | |

| } | |

| }() | |

| wg.Wait() | |

| } | |

| elapsed := time.Now().Sub(start) | |

| times := 2 * 1024 * 1024 | |

| elapsedms := float64(elapsed.Nanoseconds()) / 1000 / 1000 | |

| fmt.Printf("finished benchmark. %d times, elapsed %f ms, %f op/ms\n", times, elapsedms, float64(times)/elapsedms) | |

| } |

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

言語仕様 |

docs |

showa |

|

1 |

- Goの言語仕様における表現方法:EBNF - Wikipedia

- Template:General Category (Unicode) - Wikipedia

- identifiers

- keywords

- operators and punctuation

- literals

ホワイトスペース(スペース(U+0020)、水平タブ(U+0009)、キャリッジリターン(U+000D)、ニューライン(U+000A))は、トークンを分離する場合を除き、無視されます。

また、開業やファイルの終端があるとセミコロンが挿入されることがある。

生成物の終端にセミコロンを使用している。ただし、以下のルールでセミコロンを省略できる。

- 以下のトークンであれば、行の最後のトークンの直後に自動的にセミコロンが挿入される

- identifiers

- 整数、浮動小数点、虚数、ルーン、または文字列リテラル

- break、continue、fallthrough、returnのいずれかのキーワード

- 演算子および句読点の中の++、--、)、 ] 、 } のいずれか。

- 文を1行にまとめるために、)や}で閉じる前のセミコロンを省略できる

変数や型などのプログラムの実態をあらわす。

identifier = letter { letter | unicode_digit } .

予約済みのキーワード

break default func interface select

case defer go map struct

chan else goto package switch

const fallthrough if range type

continue for import return var

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Goで文字列のポインタ参照でアロケート |

docs |

showa |

|

1 |

- 文字列の変数のスコープがポインタ参照によって関数より外に広がったことでheapに割り当てられる

- これは実際にポインタ参照されるところまでコードが到達しなくても関数を呼び出した時点で発生する

- (あたり前田のクラッカー)

- そのため、該当箇所まで到達しなくてもメモリアロケートが発生する

勉強不足。この修正でライブラリの性能ちょっとあがったので学び。

遭遇したのはこんな感じのreflectで文字列を操作したときにみつけた。 ※再現確認のために超簡単な内容にしている。

package main

import "reflect"

func main() {

stringToString("XXX")

}

func stringToString(s string) string {

if s != "" {

return s

}

return reflect.ValueOf(&s).Elem().String() // ← ここには到達しない

}到達しないが、Benchmarkとると1allocs走ってる

> go test -bench $ -benchmem -benchtime 5s string-test

goos: linux

goarch: amd64

pkg: string-test

cpu: Intel(R) Core(TM) i7-9700 CPU @ 3.00GHz

BenchmarkReflectString-8 217355878 27.66 s/op 16 B/op 1 allocs/opなんでだろ~。reflect.ValueOf~を別の関数にしてみる。

package main

import "reflect"

func main() {

stringToString("XXX")

}

func stringToString(s string) string {

if s != "" {

return s

}

return valueOfString(s).String()

}

func valueOfString(s string) reflect.Value {

return reflect.ValueOf(&s).Elem()

}Benchmarkをとるとallocsがゼロになった!

> go test -bench $ -benchmem -benchtime 5s string-test

goos: linux

goarch: amd64

pkg: string-test

cpu: Intel(R) Core(TM) i7-9700 CPU @ 3.00GHz

BenchmarkReflectString-8 1000000000 1.391 ns/op 0 B/op 0 allocs/op次にbuildでgcflagsフラグをつかってコンパイル時の最適化の内容をみてみる。

まず前者のメモリアロケートが発生するパターン。

stringToString関数で変数sがヒープに移動されている。つまり、stringToString関数が呼び出すと引数の変数sはスタックじゃなくてヒープにおかれる。

> go build -gcflags '-m' main.go

# command-line-arguments

./main.go:14:24: inlining call to reflect.ValueOf

./main.go:14:42: inlining call to reflect.Value.String

./main.go:14:24: inlining call to reflect.escapes

./main.go:14:24: inlining call to reflect.unpackEface

./main.go:14:24: inlining call to reflect.(*rtype).Kind

./main.go:14:24: inlining call to reflect.ifaceIndir

./main.go:14:42: inlining call to reflect.flag.kind

./main.go:5:6: can inline main

./main.go:9:21: moved to heap: s次に後者。

stringToString関数でleaking paramが起きている。これはぐぐるとGoのコンパイル時の最適化結果を確認する(インライン化の条件についても記載) - Qiitaより、関数が終わっても変数が残るというアラート。なので、関数呼び出し時点ではヒープに変数が置かれてはいない。

> go build -gcflags '-m' main.go

# command-line-arguments

./main.go:19:24: inlining call to reflect.ValueOf

./main.go:19:24: inlining call to reflect.escapes

./main.go:19:24: inlining call to reflect.unpackEface

./main.go:19:24: inlining call to reflect.(*rtype).Kind

./main.go:19:24: inlining call to reflect.ifaceIndir

./main.go:15:32: inlining call to reflect.Value.String

./main.go:15:32: inlining call to reflect.flag.kind

./main.go:5:6: can inline main

./main.go:18:20: moved to heap: s

./main.go:9:21: leaking param: s別に関数にしなくても別の変数に置き換えても問題なし。

func stringToString(s string) string {

if s != "" {

return s

}

t := s

return reflect.ValueOf(&t).Elem().String()

}

// > go test -bench $ -benchmem -benchtime 5s -memprofile mem.out string-test

// goos: linux

// goarch: amd64

// pkg: string-test

// cpu: Intel(R) Core(TM) i7-9700 CPU @ 3.00GHz

// BenchmarkReflectString-8 1000000000 1.476 ns/op 0 B/op 0 allocs/op| title | type | weight | lastmod | |

|---|---|---|---|---|

Test |

docs |

1 |

|

関数名の接頭辞にBenchmarkをつけて*testing.Bを受け取る関数をつくるとベンチマークをとれる。

-benchmemでベンチマーク中のメモリの情報がとれる。

-cpuprofile [ファイルパス]: ベンチマーク中のCPUのプロファイルを取得し出力します。-memprofile [ファイルパス]: ベンチマーク中のmemoryアロケーションのプロファイルを取得し出力します。-trace [ファイルパス]: ベンチマーク中のtraceを取得し出力します。-gcflags: gcコンパイラにわたすフラグを設定できる。-mを渡すと最適化の結果を確認できる。

go test -benchmem -cpuprofile pprof/cpu.out -memprofile pprof/mem.out -bench BenchmarkCtable github.com/showa-93/hashing/hashtable取得したprofileをwebで参照する。

go tool pprof -http ":8080" pprof/cpu.out| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Java |

docs |

showa |

|

100300 |

- Java7からJava16までの変遷。 - Qiita

- finalについて

- Javaのfinalを大解剖 finalの全てがここにある!!

- 完全に理解した

- Javaのfinalを大解剖 finalの全てがここにある!!

- JavaBeans

- 再利用可能なモジュール化されたプログラムを作成するための仕様

- (Java)新人向けにJavaBeansの直列化やフィールド・プロパティの謎をPOJOとの違いを交えて解説 - Qiita

- 非同期処理

Threadで非同期処理をおこなう別のスレッドを動かせる- 「

Threadの継承したクラス」または「Runnable を実装したクラス」を実行体として利用できる - Javaのスレッド(Thread)を使いこなすコツを、基礎からしっかり伝授

- Callbackや共通の変数で値の受け渡しをおこなう。

- 排他制御

synchronizedブロック- 識別子で指定したブロックそのものを排他制御させる。マルチスレッドで同時に実行されることを防げる

- ロック対象は同一のインスタンスのみ

synchronized識別子- メソッドそのものを排他制御させる。マルチスレッドで同時に実行されることを防げる

ReentrantLockクラス- 明示的にロック制御可能

- lock取得後try-catchで囲んで、finallyで必ずロックを開放する

atomicなんたら- 単一の変数などの加算代入などの原子性を担保して排他制御できる

- ラムダ式やメソッドの参照に利用するインターフェースたち

Stream- Collectionの操作を遅延評価で行う専用のオブジェクト

- 拡張性を考慮された結果、Listに直接生やすのではなく、一度stream()を挟む形になっているらしい、

- https://qiita.com/huge-book-storage/items/79fe8bd0de330e9ed1f7

- gradlew

- Gradle Wrapperのコマンド

- 共通の設定済みのGradleを配布できる形にしたもの

gradle wrappergradlew dependencies- 依存関係にあるライブラリをダウンロードする

gradle bootBuildImage

- build.gradle

-

groovyで記述できるビルド定義

-

dependencies

- ビルド時に必要なライブラリを定義している

- Gradleのdependenciesはどう書くべきか | Korean-Man in Tokyo

dependencies { implementation 'org.groovy:groovy:2.2.0@jar' implementation group: 'org.groovy', name: 'groovy', version: '2.2.0', ext: 'jar' }

-

実行可能なスタンドアロンのSpringベースのアプリケーションを作成できるフレームワーク。 デフォルトのロギングシステムはlogbackが利用されている→Spring Boot でロギングライブラリをLog4j2にする - Qiita https://spring.pleiades.io/spring-framework/docs/current/reference/html/

- SpringのDIコンテナーの読み込み

@ComponentScan(@SpringBootApplication)のアノテーションがついているクラスのパッケージとその配下のクラスに存在する@Component(またはそれが含まれるアノテーション)がついているクラスを走査し、BeanをDIコンテナに登録する。 https://github.com/kazuki43zoo/spring-study/tree/master/memos/ioc-container

- Bean

- Springコンテナで管理させたいBean(オブジェクト)を生成するメソッドにつける

@Configurationをつけたクラスで定義できる- Springコンテナによってインスタンス化され、

@Autowiredまたは@Injectを付与したフィールドにDIされる - Java Beansと異なり

Java.io.Serializableを実装する必要がない - サードパーティライブラリのクラスを利用する場合に利用することが多い

- 【Spring】Beanのライフサイクル〜生成から破棄まで〜 - Qiita

- Beanを生成、破棄するFactoryのインターフェース

- Component

- SpringのDIコンテナで管理させ、

@AutowireなどでDIできるようになる

- SpringのDIコンテナで管理させ、

- ComponentScan

- このクラスのパッケージ配下で@Component, @Service, @Repository, @Controller, @RestController, @Configuration,@NamedつきのクラスをDIコンテナに登録します。

- RestControllerAdvice

- 共通のエラーハンドリングのクラスを表す

- 各メソッドに

@ExceptionHandlerでハンドリングする例外を指定することで例外別のエラー処理を作成できる @ExceptionHandlerは通常のコントローラ内のメソッドでアノテーションを指定するとコントローラ別で例外処理できる

- 各メソッドに

- Spring-boot-exception-handling - Dev Guides

- アドバイスの作成3 - @ControllerAdvice · 独習Spring

- 共通のエラーハンドリングのクラスを表す

アノテーションをつけることでコンパイル時にコードを自動生成するライブラリ 同一のコードを記載することで発生する煩雑さをなくし、コードの可読性を向上させられる

使いたいロギングライブラリをプラグインできるようにするファサード。 SLF4J自体はロギングのインターフェースであり、このインターフェースに対応した実装のロギングシステムを設定で切り替えられる。 共通のインターフェースでロギングライブラリの詳細を知らずとも利用でき、インターフェースが共通なため他のライブラリに切り替えることも容易。

- ビルドツールの違いって何?

- ビルドツール make / ant / maven / gradle ざっくり理解メモ - Qiita

- Maven

- Gradle

- サーブレットコンテナってなに

- Java Servletの実行環境。Webコンテナとも呼ばれる

- Tomcat

- Jetty

- Webサーバー→サーブレットコンテナ→サーブレット

- ビジネスロジック以外の処理を提供してくれたりする

- Spring Bootの場合、TomCatかなんかがくみこまれてる

- Java Servletの実行環境。Webコンテナとも呼ばれる

- Spring Bootビルド後のコントローラってどうなってるの。というかルーターの生成かな。

- Spring boot側が管理してるけど、最初のロードのときにやってんのかな

- WebサーバーとSpring bootとかの関係性(通信経路)がぴんとこん

- spring bootは、tomcatが同梱された実行ファイルを生成するぜ

- なので、spring bootで開発したらそのまま動かせる

- さくっと理解するSpring bootの仕組み

- エラーハンドリングってどうしてるの

- 一番大本のエラーハンドリングするコントローラがつくれるからそこで任意の例外を補足するか、個別で補足するか

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

Kubernates |

docs |

showa |

|

100800 |

# cluster 作成のコンフィグファイル

kind: Cluster

apiVersion: kind.x-k8s.io/v1alpha4

nodes:

role: control-plane

role: worker

role: worker# clusterを作る --nameを指定しない場合、"kind"でつくられる

kind create cluster --config k8s.yamlKubernetesはAPIを通じて操作している。cuiのkubectlはマスターノードのkube-apiserverに対して、yaml形式やjson形式のマニフェストを送信してオブジェクト(ポッド、コントローラ、サービスetc...)を操作する。

ワークロードは、オブジェクトのカテゴリを表す用語として用いられ、コンテナとポッド、そして、コントローラのグループを指しています。これらは、アプリケーションやシステム機能を担うコンテナの実行を管理するために使用されます。

- フロントエンド処理

- バックエンド処理

- バッチ処理

- システム運用処理

コンテナの起動に設定できる項目は、引数や環境変数、永続ボリュームのマウント先のパス、CPU使用時間やメモリ容量の要求量や上限値、ヘルスチェック方法、コンテナ起動時の実行コマンド、イメージ名などがあります。

コンテナを実行するためのオブジェクトです。ポッドは1つまたは複数のコンテナを内包しており、その構造が、エンドウ豆の鞘(さや)が豆を内包する様子と似ています。このことから、このオブジェクトは鞘を意味する英単語のPodで表現されています。状態は保持しないので、起動と削除しかありません。IPはエフェメラルなため、Podへのアクセスはservice名を利用します。

- ポッド内部のコンテナを外部に公開できる

- ポッド内部のコンテナはlocalhostのIPアドレスとポート番号で互いに通信できる

- ポッド内部のコンテナは、ポッドのボリュームをコンテナからクロスマウントして、ポッド内でファイルシステムを共有できる

- ポッドは内部のコンテナの監視設定できる

- ポッドの起動後、初期化専用コンテナ(initContainers)をほかのコンテナ起動前に実行できる。

正常終了するとポッド内の他コンテナが起動される - 活性プローブ(livenessProbe)が問題を検知すると、コンテナを強制終了して再び起動することで回復を試みる

- 準備状態プローブ(readinessProbe)は真を返すまで、サービスオブジェクトはポッドへリクエストを転送しない

- 削除要求があった場合、終了要求シグナル(SIGTERM)が送信

猶予期間過ぎて終了されていない場合、SIGKILLされる

コンテナをブラックボックスとして扱い、再利用性の高い複数のコンテナを組み合わせて利用するパターン。

https://kubernetes.io/blog/2015/06/the-distributed-system-toolkit-patterns/

「コントローラ」は、ポッドの実行を制御するオブジェクトであり、処理の種類に応じた複数のコントローラを使い分けなければなりません。たとえば、クライアントサーバーモデルに適した「デプロイメント」コントローラでは、サーバー役のポッドの数が、なんらかの原因で目標設定値より少なくなったら、目標値を維持するようにポッドを起動します。また、バッチ処理用の「ジョブ」コントローラでは、バッチ処理が正常終了するまで再実行を繰り返し、正常終了したらログが参照できるようにポッドの削除を保留します。

- Deployment-ポッドの起動と停止を迅速に実行するよう振る舞い、稼働中ポッドの順次置き換え、オートスケーラーとの連動、さらに、高可用性構成が可能という特徴があり、オールラウンドに適用できます。

- StatefulSet-ポッドと永続ボリュームの組み合わせで制御を行い、永続ボリュームの保護を優先します。

- Job-バッチ処理のコンテナが正常終了するまで再試行を繰り返すコントローラです。ポッドの実行回数、同時実行数、試行回数の上限を設定して実行、削除されるまでログを保持する

- CronJob-時刻指定で定期的に前述の「ジョブ」を生成します。UNIXに実装されるcronと同じ形式で、ジョブの生成時刻を設定できます。

- DaemonSet-K8sクラスタの全ノードで、同じポッドを実行するためにあります。システム運用の自動化に適しています。

- ReplicaSet-デプロイメントコントローラと連動して、ポッドのレプリカ数の管理を担当します。

-

Scale

Replicaの値を変更してpodの数を増減させる機能。CPU使用率と比例して自動でスケールさせるオートスケール機能がある。 podを増やす過程でk8sの計算資源が不足するとノードが増設されるまでpodの増設は保留される。- 水平ポッドオートスケーラ (Horizontal Pod Autoscaler: HPA)

-

CPU稼働時間を監視して指定されたCPU使用率以下になるようにポッドのレプリカ数が調整される

-

CPU稼働時間→例えば、200ms/sだと 1秒あたり200ミリ秒のCPU時間に相当

-

nodeに1core割り当てられていたら、1000ms/s使えるので、5つのポッドが使える。

- クラスタオートスケーラ(Cluster Autoscaler: CA)

-

RollOut

アプリケーションコンテナの更新。通常の適用と同様にkubectl apply -fで適用可能。進行中はリクエストの処理負荷に対処できるポッド数を残して停止できるポッド数(停止許容数)だけ古いポッドを停止する。停止許容数に加えた数だけreplicasの数を上限としてポッドを起動して新しいコンテナへの更新を行う。

RollingUpdateStrategyがロールアウトの設定。kubectl describe deployment web-deployで核にできる。- RollBack

- ロールアウト前の古いコンテナの状態に戻すためにポッドを入れ替えていく。

kubectl rollout undo deployment {resource name}

-

自己回復機能

ポッドが内包するすべてのコンテナが正常終了するまで再試行する。再試行回数の上限が達するとジョブが中断される。ノード障害でポッドが失われた場合、別のノードで再スタートする。ポッドはジョブが削除されるまで保持される。

CronJobの場合、指定時刻のたびにポッドを生成して実行します。決められた保存世代数を超えるとガベージコレクションというコントローラを使って終了済みのポッドを削除する。

ポッドと永続ボリュームの対応関係を厳密に管理し、永続ボリュームのデータ保護を優先するようにふるまう。

ステートフルセット管理下のポッドは、レプリカセットと連携したハッシュ文字ではなく、連番を付与して命名される。

ボリューム名もポッドとの対応付けが明確になるように末尾に連番を付与する。

ヘッドレスサービスで設定すること。IPは固定できないので、内部DNSで解決するようにする。

すべてのノードでポッドを実行するためのコントローラ。管理下にあるpodをk8sクラスタの全ノードで稼働するように制御する。ノードが削除されると、その管理下のポッドがそのノードから削除される。ノードセレクタで一部のノードに限定できる。

メッセージブローカーと合わせて利用する。ジョブを初期化するdocker containerを用意して、値をメッセージブローカーに登録する。

そして、kubeAPIを利用して動的にmanifestを作って、JobControllerでメッセージを受け取って処理させる。

高良真穂. 15Stepで習得 Dockerから入るKubernetes (Kindle の位置No.3738-3739). 株式会社リックテレコム. Kindle 版.

コンテナ内のアプリケーションの設定やパスワードなどの情報は、デプロイされた「名前空間」から取得することが推奨されています。それを促進するためのオブジェクトとして、設定を保存する「コンフィグマップ(ConfigMap)」と、パスワードなど秘匿情報を保存する「シークレット(Secret)」があります。

Kubernetesの「サービス」は、ポッドとサービス名とを具体的に紐付ける役割を負います。つまり、「処理のサービス」を提供するサーバー役のポッドが、クライアントのリクエストを受け取れるようにするために、「サービス」は代表IPアドレスを取得して内部DNSへ登録するなどを担当します。さらに、代表IPアドレスへのリクエストトラフィックを該当のポット群へ転送する負荷分散の設定も担当します。

-

ロードバランサーの役割を持ち、ポッドを代表するIPアドレスを獲得して、クライアントのリクエストを受ける。

-

オブジェクト生成時にサービス名と代表IPアドレスを内部DNSへ登録する。これによりクライアントは、サービスの名前からその代表IPアドレスを取得できる。

-

サービスがリクエストを転送するべきポッドを選別するために、サービスのセレクターにセットされたラベルと一致するポッドを選び出し、そのIPアドレスへリクエストを転送する

-

サービスのオブジェクト存在時に起動されるポッドのコンテナには、サービスへアクセスするための環境変数が自動的に設定されるようになる。

-

サービスには4種のサービスタイプがあり、クライアントの範囲をK8sクラスタの内部に留めるか、外部まで対象とするか、また反対に、K8sクラスタ外部のIPアドレスへ転送するかを設定する。

| Service Type | Access Range and Method |

|---|---|

| Cluster IP | デフォルト。ポッドネットワーク上のポッドから内部DNSに登録された名前でアクセスできる |

| NodePort | CusterIP のアクセス可能範囲に加えて、K8sクラスタ外のクライアントもIPとPortを指定してアクセスできる。ノード横断でリクエストの分配が可能 |

| LoadBalancer | NodePortのアクセス可能範囲に加えて、K8sクラスタ外のクライアントも代表IPアドレスとプロトコルのデフォルトポート番号でアクセスできる |

| ExternalName | K8sクラスタ内のポッドネットワーク上のクライアントから外部のIPアドレスを名前でアクセスできる |

- セッションアフィニティ 代表IPアドレスで受けたリクエストを常にポッドに送信するキー項目。 ClientIPをセットするとクライアントのIPアドレスで転送先を固定できる

ストレージシステムの違いを隠蔽して、コンテナが共通したAPIによって「永続ボリューム(Persistent Volume)」をアクセスできるようにしています。これを実現するためにストレージを階層的に抽象化するオブジェクト群が用意されています。 PVのプロビジョニングは、PVC(永続ボリューム要求)の作成に伴って自動的に行われる。

storage

| 種類 | 範囲 | col3 |

|---|---|---|

| emptyDir | 同一ポッド内ファイル共有 | ポッドから一時的に利用する仕組み。 |

| ポッド終了とともに削除される。 | ||

| hostPath | 同一ノード内ファイル共有 | ポッドとともに削除されない。 外部ストレージを利用できない場合の代替手段。 |

| local | 同一ノード内ファイル共有 | ノードのディスクをコンテナからマウントして利用 |

| 外部 | ストレージシステムの方式による | NFSのようなプロトコルだとノード間で 永続ボリュームを共有できる |

Roll-Based Access Control(RBAC) 。クラスタ内で役割の権限を定義できるアクセスコントロールのこと。サービスアカウントが対応しており、サービスアカウントはユーザ個人でなく、コンテナに対して特権を付与する。namespace内で一意である。

TODO:よくわからん。podに与える権限をコントロールしてる感じ? https://kubernetes.io/ja/docs/reference/access-authn-authz/authentication/

リバースプロキシ。 k8sクラスタの外部からのリクエストをK8sクラスタ内部のアプリケーションへつなぐためのAPIオブジェクト。 SSL/TLS暗号化やセッションアフィニティなどの機能を備えている。

- 公開用URLとアプリケーションの対応付け

- パス部分に複数のアプリケーションを紐づけることができる!

- ingress→Serviceに転送される

- 「仮想ホスト」機能で、1つのパブリックIPアドレスを共有して、ドメイン名によって転送先を設定できる

metadataのannotation

- kubernetes.io/ingress.class:'nginx': 複数のingressが動いている場合の送り先設定

- nginx.ingress.kubernetes.io/rewrite-target:/ : URLパスの書き換え要求

論理的にクラスタを区分することができる。名前空間を利用して論理的にコマンドの有効範囲を制限できる。

名前空間は、1つの物理的なk8sをカオス化して、複数の占有環境としての利用を設定できる。

-

スコープ設定

-

リソースの割り当て

-

アクセス制御(Calico)

-

default: デフォルトの名前空間

-

kube-public: すべてのユーザーが読める空間

-

kube-system: システムやアドオンによって利用される名前空間

- パスワード、トークンまたはキーなどの機密情報を保持できる

- Base64エンコーディングする必要がある

- 名前空間やサービスアカウントを作成した際のトークンを保存したシークレットが名前空間に自動生成される

- ポッドの環境変数やボリューム、ファイルとして利用できる

- tls証明書の設定とかもできるよ

- 暗号化機能を有効にできる

- ポッドを起動する前にシークレットを生成する必要がある

- Base64エンコードする必要がない

- シークレットと異なり定期的に更新チェックされており自動更新されて反映される

-

ヘルスチェック

KubernetesのチェックするAPIに対応するコマンドやHTTPのアクセスパスを実装することでヘルスチェック苦悩を活かせる。 -

コンテナの終了

SGTERMをアプリケーションが受け取るとコンテナを停止するための終了処理を開始するように実装する必要がある。 -

稼働ログ

DockerやKubernetesは集中型ロギング死すt無へ接続できる。そのため、アプリケーションのログは一貫して標準出力や標準エラー出力へ書き出すように実装する。 -

終了ステータス

プロセス「PID=1」のExitコードがコンテナの終了コードとしてセットされる。 終了コード=0で終了すると、正常終了。0以外で終了すると失敗終了として扱う。

アプリケーションはこの終了コードを実装する必要がある。

kubernatesを用いた継続的な開発体験を実現するデプロイツール

Kubernetesのアプリケーション開発で楽をしたい。そうだ、Skaffoldを使ってみよう! | Skyarch Broadcasting

| title | type | weight | lastmod | |

|---|---|---|---|---|

Logging |

docs |

100900 |

|

| title | type | weight | lastmod | |

|---|---|---|---|---|

開発手法 |

docs |

7000 |

|

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

BDD |

docs |

showa |

|

1 |

-

- CucumberっていうBDDの支援ツール的なさむしんぐ

| title | type | author | lastmod | waight | |

|---|---|---|---|---|---|

DNS |

docs |

showa |

|

1 |

Domain Name System(ドメイン・ネーム・システム)

インターネット上のドメイン名とIPアドレスの対応付けを階層化と委任におる分散管理しているシステム。

ドメイン名に対応する形で管理範囲を階層化する。サブドメインのゾーンを委任することで親子関係をつくる。

委任は、親のネームサーバーで委任先の子のネームサーバーの委任情報を登録することでおこなう。

ルートのネームサーバーから順にたどることで、ドメイン名のIPアドレスを取得できる仕組み。

DNSの通信にはTCPとUDPをサポートする必要がある。

ドメイン名の登録管理する組織。以下のような機能をもつ。

- レジストリデータベースの運用管理

- ポリシーに基づいた登録規則の策定

- 登録申請の受付

- Whoisサービスの提供

- ネームサーバーの運用

ドメイン名の登録者からの申請の取り次ぎ。レジストリとことなり、複数のレジストラが存在する。

登録者とレジストラを取り次ぐ「リセラ」という事業者も存在する。

TLDによってレジストラの役割も異なるが、おおよそ下記。

- 登録者からの登録申請の受付

- レジストリデータベースの登録依頼

- Whoisサービスの提供

- 登録者情報の管理

別称:DNSクライアント

利用端末で動作(OSに組み込まれている)、フルリゾルバに名前解決を依頼するDNSのクライアント。

リゾルバ自前実装してるnetパッケージ

別称:キャッシュDNSサーバー、参照サーバー、DNSサーバー

名前解決要求をスタブリゾルバーから受け付け、問い合わせを受けたドメイン名がキャッシュされている場合、スタブリゾルバにその結果を応答する。

存在しない場合、権威サーバーへ問い合わせを行う。問い合わせ結果である委任情報やIPアドレスをキャッシュする。

- ヒントファイル

ルートの権威サーバーの問い合わせ先はフルリゾルバー自身でもっている

初回の名前解決の前に読み込まれる。 - プライミング

最新のルートサーバーの一覧を得る仕組み

初回の名前解決時にヒントファイルを元にルートサーバーに問い合わせる

スタブリゾルバーとフルリゾルバーの間に配置され、問い合わせと応答を中継する。

利用メリット

- フルリゾルバー相当の機能を簡易的に実装できる

- ネットワーク内の利用者が使うフルリゾルバーのDNS設定を各端末で変更する必要がなくなる

- フォワーダーで一括で対応する

別称:権威DNSサーバー、ゾーンサーバー、DNSサーバー

委任を受けたゾーンの情報と委任しているゾーンの委任情報を保持するネームサーバー。

フルリゾルバーからの問い合わせを受けて、自分の保持する情報を応答する。

権威サーバーはゾーンの設定内容を「リソースレコード」という形式で保存している。

複数台の権威サーバーでフルリゾルバーからのアクセスを分散させる。

メインの権威サーバーを「プライマリサーバー」、ゾーン転送によりコピーされた権威サーバーを「セカンダリサーバー」と呼ぶ。

- DNS NOTIFY:プライマリサーバーでゾーンデータが更新された場合、セカンダリサーバーに通知する。

- ゾーン転送方法

- リソースレコードセット(RRset)

- 同じドメイン名、タイプ、クラスでデータが異なる集合

- ゾーンファイル

- 権威サーバーが読み込むファイル。リソースレコードをまとめたもの

- code: ゾーンファイル

- example.jp. IN SOA (

- ns1.example.jp. ; MNAME

- postmaster.example.jp. ; RNAME

- 2021013001 ; SERIAL

- 3600 ; REFRESH

- 900 ; RETRY

- 604800 ; EXPIRE

- 3600 ; MINIMUM )

- example.jp. IN NS ns1.example.jp

- example.jp. IN NS ns2.example.jp

- ns1.example.jp IN A 192.0.2.11

- ns2.example.jp IN A 192.0.2.12

- example.jp. IN SOA (

リソースレコード

| 項目 | 説明 |

|---|---|

| ドメイン名 | 問い合わせで指定されたドメイン名。同じドメイン名の場合、2行目以降は省略可。 |

| TTL | Time to Live。リソースレコードのキャッシュ時間。 |

| クラス | ネットワークの種類。「IN」 |

| タイプ | 情報の種類。 |

| データ | リソースレコードのデータ |

| リソースレコードタイプ |

| タイプ | 内容 | 備考 |

|---|---|---|

| A | リソースのデータがIPv4アドレス | 委任情報としてネームサーバーのアドレス情報の登録(グルーコード) |

| AAAA | リソースのデータがIPv6アドレス | 上同 |

| NS | ゾーンの権威サーバーのホスト名 | ゾーン頂点に設定する場合とサブドメインの委任情報 |

| MX | ドメイン名宛の電子メールの配送先と優先度 | |

| SOA | ゾーンの管理に関する基本的な情報 | Start of Authority |

| CNAME | ドメイン名に対する正式名 | 例えばcdnのドメイン名を指定すると、名前解決をフルリゾルバがおこなう |